bawił się ktoś może w robienie customowego monitoringu dla Airflow?

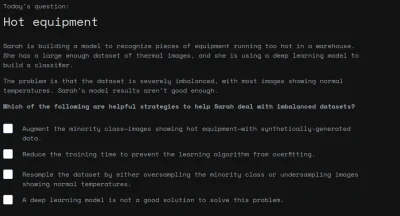

medytuję nad naklepaniem jakiegoś dashboarda który będzie zbierał statusy wykonania DAGów i pokazywał wszystko w jednym miejscu, tylko jeszcze nie wiem czy to sensowny pomysł (bo cuda niewidy pan hindus czasem robi z naszą instancją ) a nie jestem ownerem i nie chce mi się ręcznie klikać ( ͡° ͜ʖ ͡°)

czyli - jaaaaakby ktoś "been there done

medytuję nad naklepaniem jakiegoś dashboarda który będzie zbierał statusy wykonania DAGów i pokazywał wszystko w jednym miejscu, tylko jeszcze nie wiem czy to sensowny pomysł (bo cuda niewidy pan hindus czasem robi z naszą instancją ) a nie jestem ownerem i nie chce mi się ręcznie klikać ( ͡° ͜ʖ ͡°)

czyli - jaaaaakby ktoś "been there done

Hej Mirki, tak sobie dlubie proste ETL w #pandas #numpy #python i glowkuje jak tu skrocic czas ladowania trzech duzych (1GB kazdy 900k x 200) CSV. Jedyne co przychodzi mi jeszcze do glowy to dorzucenie multiprocesingu bo duzo sie dzieje, z %pruna widze ze w tej chwili CPU jest waskim gardlem. Probowalem w prymitywny sposob zaladowac to w multi rozrzucajac kazdy plik na osobny

https://www.pola.rs/

Ewentualnie Pyarrow - https://arrow.apache.org/docs/python/generated/pyarrow.csv.read_csv.html