Wszystko

Wszystkie

Archiwum

Miruny spod #kartografia #kartografiaekstremalna, kojarzycie jakąś stronkę/aplikację, na której mógłbym określić macierz najkrótszych odległości drogowych dla kilku miejscowości jednocześnie?

#kiciochpyta #analizadanych #datascience

#kiciochpyta #analizadanych #datascience

- 2

Co tu się odwaliło, Ci co wyprowadzili się z Chicago nie chcieli mieszkać pod miastem. Uznali, że warto zostawić jeszcze pas spalonej ziemi pomiędzy nimi a tym miastem. XD

#demografia #datascience

#demografia #datascience

525

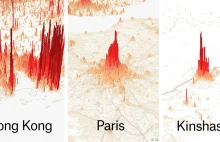

Data is beautiful - Analiza gęstości zaludnienia na świecie

Mapy z nałożonymi słupkami które wskazują gęstość zaludnienia. Pozwala to uświadomić sobie jak nierówno ułożone jest zaludnienie w niektórych miejscach na świecie.

z- 61

- #

- #

- #

- #

- #

- #

- 363

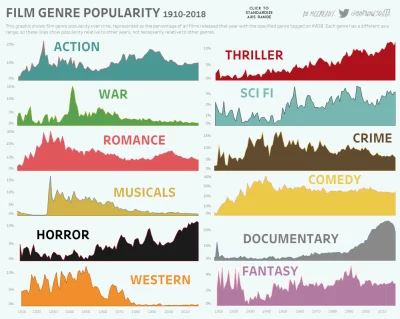

Popularność 12 gatunków filmowych w latach 1910-2018

Tutaj ta sama, ale interaktywna grafika z ponad 10 tys najlepszych filmów z ostatnich 118 lat

(Uwaga na skalę procentową po lewej)

#infog #statystyka #kultura #filmweb #netflix #filmdokumentalny #horror #musical #fantasy #komedia #thriller #analizadanych danych #datascience

Tutaj ta sama, ale interaktywna grafika z ponad 10 tys najlepszych filmów z ostatnich 118 lat

(Uwaga na skalę procentową po lewej)

#infog #statystyka #kultura #filmweb #netflix #filmdokumentalny #horror #musical #fantasy #komedia #thriller #analizadanych danych #datascience

- Armando103

- Galvay

- yeron

- konto usunięte

- konto usunięte

- +358 innych

- 82

GenreRelativePopularity

@cieliczka: ciekawe czemu filmy wojenne były tak popularne w okresie 1939-1945? Hm.. nie mogę połączyć wątków

- konto usunięte

- konto usunięte

- Naiken

- dymitrop

- Cockatrice

- +77 innych

@cieliczka: interesujące, na przykładzie thrillerów można wysnuć wniosek, że ludzie szukają w filmach mocniejszych emocji podobnie horrory tendencja wzrostowa, może nawet trochę napędzana rozwojem efektów specjalnych. Komedie constans, ludzie potrzebują uśmiechu cały czas ( ͡° ͜ʖ ͡°)

- cieliczka

- klema

- aleks0814

- vateras131

- konto usunięte

- +70 innych

Czy jak w #spark mam zaznaczone by dzielil workerow po rowno

conf.set(„spark.scheduler.mode”, „FAIR”)

ale nie dzieli po rowno xD to wina sparka czy ze cos jest zle ustawione?

#python #programowanie #datascience

conf.set(„spark.scheduler.mode”, „FAIR”)

ale nie dzieli po rowno xD to wina sparka czy ze cos jest zle ustawione?

#python #programowanie #datascience

@Tomek7: nie wiem czy to problem z danymi, ale dzieki

@luzny_lori: @Tomek7: ok chyba juz zrozumialem co jest nie tak

spark faktycznie ustawia FAIR, ale „scheduling across applications” byl na domyslnych ustawieniach i bede musial zmienic, zeby np ustawic limit „core’ow” uzywanych przez jedna aplikacje

w dokumentacji pod „job scheduling” sa te informacje jakbyscie chcieli poczytac

spark faktycznie ustawia FAIR, ale „scheduling across applications” byl na domyslnych ustawieniach i bede musial zmienic, zeby np ustawic limit „core’ow” uzywanych przez jedna aplikacje

w dokumentacji pod „job scheduling” sa te informacje jakbyscie chcieli poczytac

Cześć, czy jest ktoś kto studiuje Data Science na PJATK ? Jak ocenia to co można się tam nauczyć? Czy warto zmieniać SGH Big Data na ten kierunek ? (chociażby żeby dyplom był z informatyki) ?? Czy do ETL potrzebny jest bezwzględnie dyplom z inf. ? I czy jak mam zamiar zajmować się Data Science to jaka droga jest najlepsza (od ETL?) czy inna?

#sgh #pjatk #datascience #bigdata #etl #informatyka

#sgh #pjatk #datascience #bigdata #etl #informatyka

@trelis_morelis: Za bardzo kombinujesz kolego :)

@trelis_morelis nie zmieniaj. Pracuję w branży i zmiana nie ma najmniejszego sensu. No i do ETL nie jest potrzebny dyplom z informatyki.

- 3

Hej #datascience i #machinelearning!

Tym razem mam dla was artykuł wprowadzający w uczenie nienadzorowane. Temat trochę mniej "modny" niż uczenie nadzorowane, ale wydaje mi się, że nie mniej ciekawy. Zapraszam więc:

https://www.jakbadacdane.pl/analiza-skupien-na-przykladzie-algorytmu-k-srednich/

#jakbadacdane

Tym razem mam dla was artykuł wprowadzający w uczenie nienadzorowane. Temat trochę mniej "modny" niż uczenie nadzorowane, ale wydaje mi się, że nie mniej ciekawy. Zapraszam więc:

https://www.jakbadacdane.pl/analiza-skupien-na-przykladzie-algorytmu-k-srednich/

#jakbadacdane

#bigdata #sgh #machinelearning #datascience

Hej, słuchajcie mam takie pytanie. Jest tu jakiś absolwent Big Data na SGH i może podzielić się tym jak jest na rynku? Aktualnie studiuję BD na SGH i mam średnie odczucia. Czy jest sens to teraz rzucać i iść na jakąś informatykę ? Generalnie interesuje mnie głownie działka ML, hurtownie danych, cloud computing, czyli mniej analizy a więcej robienia. Myślałem, że kierunek ten jest właśnie idealny pod to,

Hej, słuchajcie mam takie pytanie. Jest tu jakiś absolwent Big Data na SGH i może podzielić się tym jak jest na rynku? Aktualnie studiuję BD na SGH i mam średnie odczucia. Czy jest sens to teraz rzucać i iść na jakąś informatykę ? Generalnie interesuje mnie głownie działka ML, hurtownie danych, cloud computing, czyli mniej analizy a więcej robienia. Myślałem, że kierunek ten jest właśnie idealny pod to,

@trelis_morelis: To się chyba powinno nazywać analiza danych z SAS patrząc na Wasze przedmioty.

@trelis_morelis: Sama uczelnia jak i kierunek jest szanowana - szczególnie przez działy HR, więc jak umiesz ładnie odpowiedać na pytania rekrutacyjne to spokojnie się gdzieś załapiesz. Warto szczególnie działać w kołach naukowych i działać w projektach studenckich. Jakbyś chciał iść w typowy machine learning gdzie będzie Cię już rekrutował ktoś kto sie na tym zna, no to już jakiś poziom musisz prezentować - statystyka/programowanie np w R itp.

Generalnie jak się

Generalnie jak się

- 1

#datascience #machinelearning #tensorflow #programowanie

koledzy pomocy. muszę napisać jakąś prostą sieć do tego? jak się za to zabrać żeby było łatwo i przyjemnie :D

TensorFlow, keras?

https://archive.ics.uci.edu/ml/datasets/letter+recognition

koledzy pomocy. muszę napisać jakąś prostą sieć do tego? jak się za to zabrać żeby było łatwo i przyjemnie :D

TensorFlow, keras?

https://archive.ics.uci.edu/ml/datasets/letter+recognition

0

5 rzeczy, których (prawdopodobnie) nie wiedzieliście o Elasticsearch

Elasticsearch okazał się wydajną, nierelacyjną bazą danych, zorientowaną na wyszukiwanie pełnotekstowe w dużych, rozproszonych zbiorach dokumentów. Jednocześnie oferuje on szereg mechanizmów i rozwiązań, które mają bezpośredni wpływ na otrzymywane przez nas wyniki.

z- 2

- #

- #

- #

- #

- #

- #

- 4

Hej #datascience i #machinelearning!

W tym tygodniu artykuł nieco leniwy, ale myślę, że będzie szczególnie przydatny dla programujących w #jezykr.

W artykule omawiam całkiem ciekawy pakiet o nazwie auditor. Jeśli potrzebowałeś kiedyś porównać właściwości modeli predykcyjnych w R to będzie to narzędzie w sam raz dla Ciebie:

https://www.jakbadacdane.pl/pakiet-auditor-weryfikacja-walidacja-i-analiza-bledow-modelu-w-r/

#jakbadacdane

W tym tygodniu artykuł nieco leniwy, ale myślę, że będzie szczególnie przydatny dla programujących w #jezykr.

W artykule omawiam całkiem ciekawy pakiet o nazwie auditor. Jeśli potrzebowałeś kiedyś porównać właściwości modeli predykcyjnych w R to będzie to narzędzie w sam raz dla Ciebie:

https://www.jakbadacdane.pl/pakiet-auditor-weryfikacja-walidacja-i-analiza-bledow-modelu-w-r/

#jakbadacdane

@grajlord: jest kilka firm wspierających R dla badań klinicznych - choćby Mango Solutions. Poza tym nawet sam SAS używa R. Najnowszy produkt SAS Data Mapper korzystał z kilku modułów R do trenowania AI, i wcale się z tym nie kryją.

- 1

Hej,

Mirasy mam do Was pytanie dotyczące przyszłości data science w polsce.

Studiuje sobie infę, jestem na drugim roku. Do tej pory wiadomo, robiłem to co musiałem na uczelnię, a na własną rękę uczyłem się po trochu wielu rzeczy. Grzebałem trochę w froncie, nawet pare zleceń mi wpadło po znajomych i rodzinie. Uczyłem się trochę programowania pod Androida. Ale generalnie to nie dla mnie chyba. Od kilku miesięcy dokształcam się w kierunku

Mirasy mam do Was pytanie dotyczące przyszłości data science w polsce.

Studiuje sobie infę, jestem na drugim roku. Do tej pory wiadomo, robiłem to co musiałem na uczelnię, a na własną rękę uczyłem się po trochu wielu rzeczy. Grzebałem trochę w froncie, nawet pare zleceń mi wpadło po znajomych i rodzinie. Uczyłem się trochę programowania pod Androida. Ale generalnie to nie dla mnie chyba. Od kilku miesięcy dokształcam się w kierunku

@ostry_ananas: Mało jest firm które rzeczywiście robią

data science w Polsce. Do tych lepszych musisz zajebiście ogarniać matmę i statystykę - odniosłem wręcz wrażenie, że to ważniejsze niż programowanie, takiego juniora dużo łatwiej kogoś douczyć pisania kodu - stąd rekrutacje często są bardzo wymagające. W tych gorszych często stanowisko nazywa się data scientist ale tak naprawdę zajmujesz się robieniem #!$%@? regresji w SASie. Jak znajdzie się fajną firmę to praca jest@ostry_ananas: Polecam dwie rzeczy:

1) zacznij pokazywać w sieci (blog, github, youtube, whatever), że masz pasję do danych

2) zastanów się nad szukaniem pracy zdalnej

Ścisłe wykształcenie bardzo pomaga. Ja pracuję jako Data Scientist za oceanem i za każdym raziem jak się przedstawie klientowi na początku projektu, że mam doktorat z fizyki to zaczynają słuchać co mam do powiedzenia.

1) zacznij pokazywać w sieci (blog, github, youtube, whatever), że masz pasję do danych

2) zastanów się nad szukaniem pracy zdalnej

Ścisłe wykształcenie bardzo pomaga. Ja pracuję jako Data Scientist za oceanem i za każdym raziem jak się przedstawie klientowi na początku projektu, że mam doktorat z fizyki to zaczynają słuchać co mam do powiedzenia.

- 14

Politolog, dr hab. Rafał Matyja, przygotował dla Nowej Konfederacji pogłębioną analizę wyników wyborów samorządowych 2018. Oprócz werdyktu "kto zyskał, kto stracił" dużo ciekawych statystyk, np. tabelka wieku i płci prezydentów miast w różnych kadencjach samorządu:

Znalezisko: https://www.wykop.pl/link/4718409/krajobraz-po-samorzadowej-bitwie-raport-ekspercki-nowej-konfederacji/

PS: Rafał Matyja to bardzo ciekawa i godna zaufania postać. Ostatnio wydał książkę "Wyjście awaryjne" (tu reakcja Klubu Jagiellońskiego), która - choć może nie jest porywająca jak np. książki Krasowskiego - pozwala się dużo

Znalezisko: https://www.wykop.pl/link/4718409/krajobraz-po-samorzadowej-bitwie-raport-ekspercki-nowej-konfederacji/

PS: Rafał Matyja to bardzo ciekawa i godna zaufania postać. Ostatnio wydał książkę "Wyjście awaryjne" (tu reakcja Klubu Jagiellońskiego), która - choć może nie jest porywająca jak np. książki Krasowskiego - pozwala się dużo

- konto usunięte

- konto usunięte

- wszyscy

- Roxar123

- maciekk88

- +9 innych

37

"Krajobraz po samorządowej bitwie" - raport ekspercki Nowej Konfederacji

Jak wygląda Polska po wyborach z 2018 r.? Detaliczna analiza prof. Rafała Matyi. Tl;dr w powiązanych. PS: Dużo ciekawych informacji, np.średnia wieku i odsetek kobiet prezydentów różnych kadencji samorządowych

z- 8

- #

- #

- #

- #

- #

- #

- 2

Hej.

W tym tygodniu powróciłem do problemu jakości powietrza i próby określenia gdzie było najlepiej i najgorzej w 2017 roku w Polsce. Wyszło tak sobie i nie za bardzo mam pomysł jak to ugryźć :D. Zasadniczym problemem jest mała ilość oficjalnych punktów pomiarowych. Ale o tym już w artykule ;)

https://www.jakbadacdane.pl/jakosc-powietrza-w-polsce-2-rok-2017-oczami-oddychajacego-polaka/

#jakbadacdane #datascience

W tym tygodniu powróciłem do problemu jakości powietrza i próby określenia gdzie było najlepiej i najgorzej w 2017 roku w Polsce. Wyszło tak sobie i nie za bardzo mam pomysł jak to ugryźć :D. Zasadniczym problemem jest mała ilość oficjalnych punktów pomiarowych. Ale o tym już w artykule ;)

https://www.jakbadacdane.pl/jakosc-powietrza-w-polsce-2-rok-2017-oczami-oddychajacego-polaka/

#jakbadacdane #datascience

- 2

@Avitus:

Wydaje mi się, że potrzebujesz tak naprawdę dwóch statystyk, które będziesz potem analizował we wzajemnym kontekście - jakość powietrza oraz jakość danych.

W kwestii modelowania jakości powietrza, to u siebie stosujesz dość prostą metodę średniej ważonej, ja bym się zastanowił nad jakimś modelem "przestrzennym", modelującym też korelacje, jakiś model mieszany.

Jeżeli chodzi o modelowanie jakości danych, to jakaś prosta statystyka wynikająca z liczby dostępnych punktów i odległości.

Albo można wsiąknąć

Wydaje mi się, że potrzebujesz tak naprawdę dwóch statystyk, które będziesz potem analizował we wzajemnym kontekście - jakość powietrza oraz jakość danych.

W kwestii modelowania jakości powietrza, to u siebie stosujesz dość prostą metodę średniej ważonej, ja bym się zastanowił nad jakimś modelem "przestrzennym", modelującym też korelacje, jakiś model mieszany.

Jeżeli chodzi o modelowanie jakości danych, to jakaś prosta statystyka wynikająca z liczby dostępnych punktów i odległości.

Albo można wsiąknąć

- 1

@lekkonieobecny: Wow, fajnie to wyszło. W sumie też mi się ten temat przewija cały czas w tle, ale nie ogarnąłem jeszcze na tyle heat map w Pythonie żeby było warto o tym pisać. A widziałem że faktycznie Tableau nieźle sprawdza się w takich wizualizacjach. Zdecydowanie też coś takiego muszę przygotować w Pythonie i w R ;)

- 5

Ahoj #datascience i #machinelearning. Wy to pewnie mnożycie macierze w bazach danych i inne cuda robicie. Ale może jest wśród was #newbie który jeszcze nie miał do czynienia z bazami danych. I właśnie z myślą o osobach początkujących napisałem artykuł w którym dzielę się moimi przemyśleniami na temat używania baz danych w projektach data science. Od razu ostrzegam, że temat jest na poziomie bardzo początkującym. Ale jeśli będzie popyt to z

- 0

@ja_tu_czytam: Nie obrażam się ;). I mam pewien pomysł jak to ugryźć, ale jeszcze nie przetestowany - użyć modułu dask (https://dask.org/).

W samym artykule też piszę o tym, że możemy w ogóle nie zbudować ramki danych bo zabraknie nam pamięci ( ͡° ͜ʖ ͡°).

W sumie to jest to pomysł na artykuł na przyszłość. Może faktycznie w takiej sytuacji polegnę. Ale i tak będzie o czym

W samym artykule też piszę o tym, że możemy w ogóle nie zbudować ramki danych bo zabraknie nam pamięci ( ͡° ͜ʖ ͡°).

W sumie to jest to pomysł na artykuł na przyszłość. Może faktycznie w takiej sytuacji polegnę. Ale i tak będzie o czym

Za każdą poradę, artykuł będę wdzięczny

#naukaprogramowania #matplotlib #python #programowanie #datascience #analizadanych

Po co Ci to w ogóle potrzebne? Dopasowujesz rozkład?