Hej!

Mam pytanko. Gdzie mogę znaleźć algorytmy które zostały niedawno opracowane?

Szukałem na wiki, po pracach naukowych które zostały wypuszczone od 2018 roku, oczywiście też wpisywałem mnóstwo fraz w google ale nic konkretnego nie udało mi się znaleźć ( ͡° ʖ̯ ͡°). Pewnie będę musiał szukać w #machinelearning ale też jeszcze chciałem z innej dzieciny takie algorytmy poznać.

#programowanie #algorytmy i w

Mam pytanko. Gdzie mogę znaleźć algorytmy które zostały niedawno opracowane?

Szukałem na wiki, po pracach naukowych które zostały wypuszczone od 2018 roku, oczywiście też wpisywałem mnóstwo fraz w google ale nic konkretnego nie udało mi się znaleźć ( ͡° ʖ̯ ͡°). Pewnie będę musiał szukać w #machinelearning ale też jeszcze chciałem z innej dzieciny takie algorytmy poznać.

#programowanie #algorytmy i w

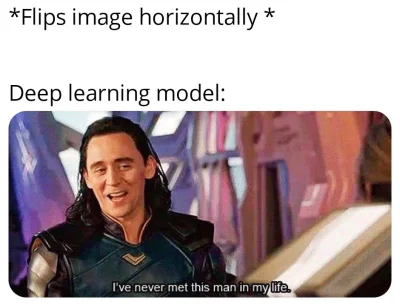

https://www.youtube.com/watch?v=oxVcokRghpE&ab_channel=CtrlShiftFace

#ukraina #wojna #putin #machinelearning #deepfake

źródło: comment_1646315105SrVkGn2V5wY45dESmGWANH.jpg

Pobierz