Wszystko

Najnowsze

Archiwum

konto usunięte via Wykop

- 1

@F2f9TkqT5b: Tu 100, podloże zawieszone na linkach:

- 0

@kropidlak: Coś im się to nie chce zsynchronizować jakby ramie było na sztywno to może by się udało.

Elon oficjalnie przeciwko AI, w dodatku razem z szurami z Twittera.

Jakieś pomysły co mu odbiło?

#technologia #nauka #sztucznainteligencja #deeplearning #elonmusk #ciekawostki

Jakieś pomysły co mu odbiło?

#technologia #nauka #sztucznainteligencja #deeplearning #elonmusk #ciekawostki

źródło: lMYvxn9

Pobierz@czlowiek_z_lisciem_na_glowie: gdzie tu jest stanowisko przeciwko Ai?

Mi też się zdarza zapytać "i co z tym powinniśmy zrobić" jak ktoś z teoriami spiskowymi sie rozkreci

Mi też się zdarza zapytać "i co z tym powinniśmy zrobić" jak ktoś z teoriami spiskowymi sie rozkreci

- 5

Protestowanie w sprawie sztucznej inteligencji rozwiązującej problemy szybciej jest jak protestowanie przeciw kalkulatorom bo ludzie liczący na liczydle stracą prace #ai #machinelearning #deeplearning #programowanie #przyszlosc

@niko444: były już takie ruchy w przeszłości, np. luddyści protestujący przeciw maszynie tkackiej

@niko444:

Ale kto protestuje, poza artystami?

Protestowanie w sprawie sztucznej inteligencji rozwiązującej problemy szybciej jest jak protestowanie przeciw kalkulatorom bo ludzie liczący na liczydle stracą prace

Ale kto protestuje, poza artystami?

- 10

Po kilku dniach zabawy wreszcie udało mi się zbudować od zera model dyfuzyjny do generacji zwierzątek. Jeszcze nie jest idealnie, ale to kwestia dość małego data setu i niskiej optymizacji mojej implementacji. No ale na razie jestem usatysfakcjonowany (⌐ ͡■ ͜ʖ ͡■).

#machinelearning #deeplearning #programowanie #sztucznainteligencja

#machinelearning #deeplearning #programowanie #sztucznainteligencja

źródło: download

PobierzIle rekordów ma ten zestaw danych? Wygląda spoko kot

- 0

@JebawczanRysionu: około 7500 ale dałem dużo agumentacji.

Siema,

Warto robić “Deep Learning Specialization” z Coursery? Koszt z tego co widziałem 50$ miesięcznie.

Jeśli chodzi o mnie to znam podstawy ML i ogarniam w miarę pythona i sql-a. Nauczę się tam czegoś? I jak na taki papierek patrza pracodawcy?

#deeplearning #datascience #machinelearning #siecineuronowe #programowanie #uczeniemaszynowe

Warto robić “Deep Learning Specialization” z Coursery? Koszt z tego co widziałem 50$ miesięcznie.

Jeśli chodzi o mnie to znam podstawy ML i ogarniam w miarę pythona i sql-a. Nauczę się tam czegoś? I jak na taki papierek patrza pracodawcy?

#deeplearning #datascience #machinelearning #siecineuronowe #programowanie #uczeniemaszynowe

- 4

Ja bardzo polecam wszystko od Pana Ng, bo tłumaczy bardzo dobrze, ale na taki płatny kurs bym się decydował tylko jeśli miałbym dość dużo czasu aby go szybko skończyć.

A odpowiadając konkretnie na Twoje pytania - jeśli podejdziesz do tego uczciwie i przerobisz cały materiał to zdecydowanie się sporo nauczysz (wg mnie jest nieźle ustrukturyzowany i ma dużo odnośników do innych źródeł).

Czy pracodawcy patrzą na takie papierki? No nie patrzą.

Przed

A odpowiadając konkretnie na Twoje pytania - jeśli podejdziesz do tego uczciwie i przerobisz cały materiał to zdecydowanie się sporo nauczysz (wg mnie jest nieźle ustrukturyzowany i ma dużo odnośników do innych źródeł).

Czy pracodawcy patrzą na takie papierki? No nie patrzą.

Przed

- 0

@Kura_Wasylisa: wydawało mi się, że dla tych z deeplearning.ai to poblokowane (bo nie są dostępne w Coursera Plus). Ale masz rację: da się robić "Audit", trzrba tylko zapisywać się na każdy kurs z osobna:

https://www.reddit.com/r/learnmachinelearning/comments/9mxae1/how_to_take_the_deeplearningai_course_for_free/

https://www.reddit.com/r/learnmachinelearning/comments/9mxae1/how_to_take_the_deeplearningai_course_for_free/

31

How Nvidia AI Robot Trained 42 Years In 32 Hours And Did THIS

Nvidia wytrenowała rękę robota z uczeniem wzmacniającym, aby miała niesamowitą zręczność przy użyciu symulacji, drastycznie przyspieszając czas szkolenia i minimalizując koszty obliczeniowe o 200 razy.

z- 12

- #

- #

- #

- #

- 4

Jednak fajne jest to #gpu A100 80 GB. Czasami nie czuć adekwatnej różnicy względem np. 3090 Ti, ale jak walnąłem sobie 6 warstwowego U-Neta na 70 mln parametrów i przetwarza mi w trakcie uczenia 30k zdjęć 128x128 na minutę to czuć moc ( ͡° ͜ʖ ͡°)

#machinelearning #deeplearning #programowanie

#machinelearning #deeplearning #programowanie

- 1

@mk321: Na uczelni mamy je na serwerze którego używam do obliczeń. Więc za darmo xD. Ale były kupione już jakiś czas temu czyli pewnie €32k za sztukę.

- 2

@Bejro: tak serio, to było, że ktoś na uczelnianym klastrze odpalił kopanie krypto i wyleciał z uczelni. Myślę, że admini to monitorują. Tak że nie polecam, chyba że chcesz skończyć jak ten od rurki w samolocie :P

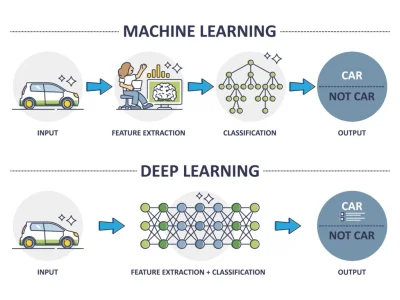

@czlowiek_z_lisciem_na_glowie: nie, do klasyfikacji przy pomocy deeplearningu też trzeba zrobić "future extraction", ten obrazek jest w ogóle strasznie uproszczony

- 1

@hetero_sapiens: starałem się w grzeczny sposób wybadać czy znasz różnicę, mogę zakładać że nie wszyscy znają, bo nie takich widziałem ananasów a ty reagujesz nerwowo jak na literówkę

- 4

- Dlaczego Wałęsa nosi wąsy?

- Lech Wałęsa nie nosi wąsów. Były prezydent Polski Lech Wałęsa jest znany ze swojej charakterystycznej brody, która stała się jego znakiem rozpoznawczym. Nie jestem w stanie powiedzieć dokładnie, dlaczego Wałęsa zdecydował się na taki wygląd, ale prawdopodobnie chodziło o wyróżnienie się i zaprezentowanie swojego indywidualizmu. Broda jest również często symbolem męskości, więc być może Wałęsa zdecydował się na nią, aby pokazać swoją silną i męską osobowość.

- Lech Wałęsa nie nosi wąsów. Były prezydent Polski Lech Wałęsa jest znany ze swojej charakterystycznej brody, która stała się jego znakiem rozpoznawczym. Nie jestem w stanie powiedzieć dokładnie, dlaczego Wałęsa zdecydował się na taki wygląd, ale prawdopodobnie chodziło o wyróżnienie się i zaprezentowanie swojego indywidualizmu. Broda jest również często symbolem męskości, więc być może Wałęsa zdecydował się na nią, aby pokazać swoją silną i męską osobowość.

konto usunięte via Wykop Mobilny (Android)

- 1

Szukam jakiejś dobrej książki do ML w Pythonie, bardziej zależy mi na części praktycznej czyli jak używać tej czy tamtej metody w scikit-learn czy innym pakiecie. Coś w stylu Deep Learning in Pyhon Cholleta czy ISLR do R ( ͡° ͜ʖ ͡°)

#python #machinelearning #deeplearning #r

#python #machinelearning #deeplearning #r

- 1

@Lonesome_road: https://www.amazon.com/Hands-Machine-Learning-Scikit-Learn-TensorFlow/dp/1098125975

Dla ocen/recenzji obczaj poprzednie edycje

Dla ocen/recenzji obczaj poprzednie edycje

@Errion: @Lonesome_road Ja aktualnie czytam druga edycje i polecam. Klasyczny ml jest cały z sklearnem + potem jeszcze więcej z sieci i tensorflow. Polecam, to jest serio spoko książka

Cześć #ml

mam pytanie, trenuje sobie sieć neuronową na powiedzmy 50 epok, i najlepsze wyniki, które w moim wypadku mierze miarą IoU, i najlepsze wyniki mam dla epoki 43 i przez następne 7 epok już się nie poprawiło. To do ewaluacji wybieram ten model, który miał najlepsze wyniki tak?

#programowanie #naukaprogramowania #machinelearning #deeplearning #python

mam pytanie, trenuje sobie sieć neuronową na powiedzmy 50 epok, i najlepsze wyniki, które w moim wypadku mierze miarą IoU, i najlepsze wyniki mam dla epoki 43 i przez następne 7 epok już się nie poprawiło. To do ewaluacji wybieram ten model, który miał najlepsze wyniki tak?

#programowanie #naukaprogramowania #machinelearning #deeplearning #python

- 2

To do ewaluacji wybieram ten model, który miał najlepsze wyniki tak?

@TheRickestRick: Ewaluację robisz po każdej epoce i to jest główna metryka. Możesz stosować early stopping ale nie musisz, finalnie wybiera się model o najlepszym wyniku na zbiorze walidacyjnym i tyle.

- 1

@Bejro: o takiej odpowiedzi szukałem, dzięki wielkie!

- 23

Tesla zaprezentowała prototyp Tesla bota.

Tak jak się spodziewałem, jego motoryka na ten moment jest co najwyżej podstawowa. Chodzi, ale bardziej powoli drepcze ostrożnie. Podejrzewam, że najmniejsza przeszkodą to beton.

Nie ma w tym nic dziwnego. Prace nad, nim rozpoczęto zaledwie ponad rok temu. Postęp do tego momentu firmy niemającej kompletnie doświadczenia z robotyka jest naprawdę imponująca. Jeżeli w takim tempie będą go rozwijali, a cena, jaką zapowiedział Musk, czyli ok. 20k $ będzie

Tak jak się spodziewałem, jego motoryka na ten moment jest co najwyżej podstawowa. Chodzi, ale bardziej powoli drepcze ostrożnie. Podejrzewam, że najmniejsza przeszkodą to beton.

Nie ma w tym nic dziwnego. Prace nad, nim rozpoczęto zaledwie ponad rok temu. Postęp do tego momentu firmy niemającej kompletnie doświadczenia z robotyka jest naprawdę imponująca. Jeżeli w takim tempie będą go rozwijali, a cena, jaką zapowiedział Musk, czyli ok. 20k $ będzie

@cyberpunkbtc: ciężko się to czytało, chaos i ilość błędów przytłaczająca nawet jak na AI (⌐ ͡■ ͜ʖ ͡■)

@cyberpunkbtc: emerytom to potrzebne są boty mlodych lasek do ruchania a nie kupa zlomu żrącego kupę pradu zeby obijać się o ściany

#anonimowemirkowyznania

#syntezatormowy #syntezamowy #deeplearning #programowanie

Przepraszam, że z anonima ale nie mam konta. Mam takie pytanie. Czy istnieje już na rynku taki program, który jest syntezatorem własnej mowy? Przykładowo napiszę jakiś tekst, a ten program to przeczyta moim własnym głosem? Szukałem na internecie i niby coś podobnego znalazłem, ale chyba tylko po angielsku. Czy po polsku już są takie syntezatory? A jeśli sam

#syntezatormowy #syntezamowy #deeplearning #programowanie

Przepraszam, że z anonima ale nie mam konta. Mam takie pytanie. Czy istnieje już na rynku taki program, który jest syntezatorem własnej mowy? Przykładowo napiszę jakiś tekst, a ten program to przeczyta moim własnym głosem? Szukałem na internecie i niby coś podobnego znalazłem, ale chyba tylko po angielsku. Czy po polsku już są takie syntezatory? A jeśli sam

- 0

Mozilla/TTS , który bazuje na chociażby na Tacotron, którego używał gość co zrobił generowanie textu głosami z Gothica i jakość tego była bardzo dobra, ale to zależało od głosu. Czasami dla postaci która miała tylko kilka linii dialogowych głos był lepszy niż dla bezimiennego który miał ich tysiące. Chyba po prostu przetrenowanie nastąpiło. Narzędzie było dostępne w necie jako API ale kilka miesięcy temu usunęli bo Polscy artyści się burzyli że ich

- 0

- 1

Dostępny jest jakiś darmowy, choćby próbny, program wykorzystujący uczenie maszynowe do wykrywanie defektów produktów? Wyobrażam sobie to tak, że wgrywam bazę zdjęć OK i bazę NG a program nauczy się rozpoznawać defekty.

#sztucznainteligencja #technologia #uczeniemaszynowe #deeplearning #programowanie #komputery #machinelearning

#sztucznainteligencja #technologia #uczeniemaszynowe #deeplearning #programowanie #komputery #machinelearning

źródło: comment_166179754377SUMJyQSdinPGVKDqxn83.jpg

Pobierz- 1

@inny_89: ta dobra :)

Jak odnowić stare filmy (powiedzmy nagrane w 240p) do 1080p? I jakich opcji użyć żeby wyglądało to naturalnie?

#edycjafilmow

#rendering

#grafikakomputerowa

#photoshop

#topaz

#edycjafilmow

#rendering

#grafikakomputerowa

#photoshop

#topaz

- 0

https://youtu.be/vzLduvnW-FA

@uefaman: Tu w grę wchodzi mozolna ręczna praca. Z tak starym i zniszczonym materiałem raczej AI sobie nie poradzić. Spróbuj Topaz AI . Mają chyba jakąś wersje za free

- 0

@kajtom: topaz video enhance próbowałem i niestety nie daje rady, ale to być może wina mojego starego komputera. Twarze wychodziły nienaturalne, jakieś powyginane.

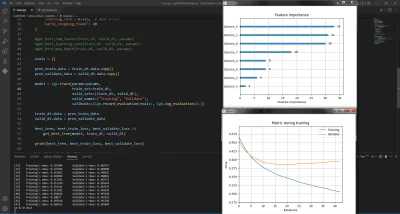

Tylko LightGBM! Microsoft to jednak potrafi.

Na tych danych daje najlepsze wyniki: https://www.kaggle.com/datasets/kumargh/pimaindiansdiabetescsv

Pierwsze miejsce LightGBM ze stratą dla walidacji 70, drugie miejsce CatBoost 77, a dalej Deep Learning i XGBoost ~80.

#programowanie #deeplearning #gradientboosting #forecasting

Na tych danych daje najlepsze wyniki: https://www.kaggle.com/datasets/kumargh/pimaindiansdiabetescsv

Pierwsze miejsce LightGBM ze stratą dla walidacji 70, drugie miejsce CatBoost 77, a dalej Deep Learning i XGBoost ~80.

#programowanie #deeplearning #gradientboosting #forecasting

źródło: comment_16607722638LJhbAgMEO1zA5htRn9FJf.jpg

Pobierz464

Teledysk stworzony w całości przez sztuczną inteligencję

Sztuczna inteligencja stworzyła teledysk w 4K zsynchronizowany czasowo z muzyką i śpiewanym tekstem

z- 61

- #

- #

- #

- #

- #

- #

- 0

Pytanie dla doświadczonych r------------y w branży #ai bo widzialem jakieś kursy z budowania modeli które nie wymagają programowania, robi się je chyba za pomocą google techable. Dość ciekawe nie powiem i myśle czy nie kupić.

Co o tym myślicie, to jest na poważnie, możliwości są porównywalne do tych kodując tradycyjnie standardowe modele w #python?

#machinelearning #ml #sztucznainteligencja #deeplearning #

Co o tym myślicie, to jest na poważnie, możliwości są porównywalne do tych kodując tradycyjnie standardowe modele w #python?

#machinelearning #ml #sztucznainteligencja #deeplearning #

@msea940: ale jakie modele, bo z tego co widzę to służy to do obrazów i dzwięków. Pytanie jest bardziej co chcesz sam zrobić, bo jeśli np. ogarnąć robotę z ml w finansach to widzę to słabo.

@msea940: widzę tylko tyle co tutaj https://teachablemachine.withgoogle.com/. Podeślij link do kursu.

#technologia #sztucznainteligencja #chatgpt #uczeniemaszynowe #deeplearning #programowanie #pytaniedoeksperta