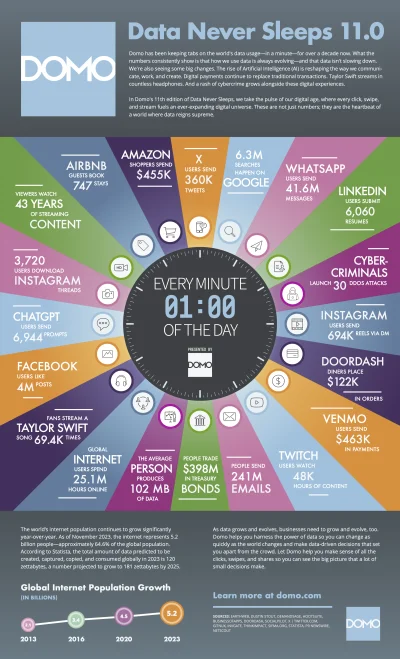

Pracuje od kilku lat w #testowanieoprogramowania jednak widzę że ilość ofert na stanowiska testerskie jest coraz mniejsza.

Myśle o zmianie zmianie na #bigdata #analizadanych #datascience #businessintelligence bo ilość ofert w tym obszarze jest kilka razy większa niż na #qa.

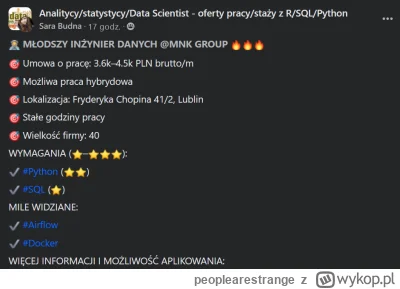

Doświadczenie mam głównie jako tester manualny, znam podstawy pythona i js (używane do testów automatycznych).

Jaki

Mirki, wybieram się w tym roku na studia podyplomowe big data. Zastanawiam się nad Politechniką Warszawską i SGH. Macie jakieś opinie na temat tych studiów? Które byście wybrali? Który program wydaje wam się lepszy?

1. https://www.sgh.waw.pl/studia-podyplomowe-i-mba/transformacja-cyfrowa/studia-podyplomowe-inzynieria-danych-big-data

2. https://ds.ii.pw.edu.pl/bigdata.html

#bigdata #korposwiat #programista15k #programowanie

źródło: praca

Pobierz