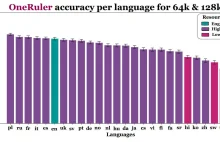

Po pierwsze - tokenizacja nie jest liniowa- różne języki faktycznie rozbijają się na różną liczbę tokenów, ale to wpływa zarówno na stóg (kontekst), jak i na igłę (fragment do znalezienia) -nie ma prostego „ułatwienia”, bo oba elementy rosną proporcjonalnie

Dwa - modele są trenowane na semantyce, nie na czystej długości - LLM rozpoznaje wzorce znaczeniowe, a nie tylko kształty tokenów. Jeśli język ma bardziej jednoznaczną lub charakterystyczną strukturę (np. fleksja

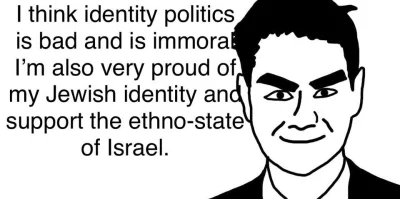

@retall: istnieje różnica między np Polskim nacjonalizmem, który opiera się na całkowicie innych wartościach niż ten niemiecki czy rosyjski, a (chyba dosłownie z drugiej strony spektrum) żydowskim, który zarówno z tej religijnej jak i świeckiej strony zakłada, że nie-żydzi to nawet nie ludzie, tylko zwierzęta, bydło w kształcie człowieka

źródło: Screenshot_20230627_144720_Gallery

Pobierz