Wie ktos

Wszystko

Najnowsze

Archiwum

6

Wideorozmowy z własną wyobraźnią - NVIDIA Maxine

NVIDIA Maxine ™ to pakiet SDK z akceleracją GPU z najnowocześniejszymi funkcjami sztucznej inteligencji dla programistów do tworzenia aplikacji do wirtualnej współpracy i tworzenia treści, takich jak wideokonferencje i transmisje na żywo.

z- 3

- #

- #

- #

- #

- #

- #

332

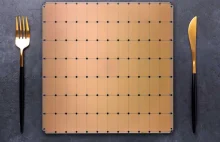

Rekordowy procesor dla sztucznej inteligencji: zawiera 2,6 bilionów tranzystorów

Przed rokiem firma Cerebras Systems zaprezentowała największy w historii procesor o gigantycznej mocy obliczeniowej, który pokonał najpotężniejszy superkomputer. Teraz firma ogłosiła, że stworzyła drugą wersję (WSE 2), która ma ponaddwukrotnie więcej tranzystorów, rdzeni i pamięci niż WSE 1.

z- 73

- #

- #

- #

- #

- #

- 0

Wie ktos

1

Czy AI może stworzyć nowe piosenki Kurta Cobaina? Albo malować dzieła sztuki?

AI pomogła stworzyć nowe piosenki Jima Morrisona, Jimi Hendrixa, Amy Winehouse i Kurta Cobaina oraz wiele innych dzieł sztuki.

z- 4

- #

- #

- #

- #

- #

- #

- 30

W tygodniowych odstępach będę publikował takie zes†awienia ciekawych materiałów, które znalazłem. Dzięki temu nie dość, że wy będziecie na bieżąco, to ja jeszcze będę miał motywację do ugruntowania mojej wiedzy :)

--------------------------------------------------------------------------------------------------------------

1. Neuralink - Małpa

- 1

nie można zakazać matematyki

#europa

potrzymaj mi p--o

ARTIFICIAL INTELLIGENCE TECHNIQUES AND APPROACHES

- 0

ale musisz poinformować

@Hauleth: poinformować, zarejestrować i wykonać sam-sprawdzić czy dane które wykorzystałęś są dostatecznie wysokiej jakości pozbawionej "skrzywienia" które mogłoby dyskryminować ludzi na podstawie określonych cech pod groźbą kary do 20mln €

https://twitter.com/omertene/status/1382200212391931906

tutaj masz tweeta z linkiem do rzekomego szkicu

data zakażenia + informacje o aktywności z tygodnia poprzedzającego.

Tj.

- czy dana osoba robiła zakupy w sklepie wielkopowierzchniowym,

- czy uczestniczyła w mszy,

- czy była na siłowni,

- 0

Właśnie to będzie ten x którego model będzie szukał

- 0

- 0

https://www.youtube.com/watch?v=4Gac5I64LM4&t=395s

Mógłaby ktoś zobaczyć pierwszą minutę tego filmu? Skąd się wzieło że suma w1x1 + w2x2... i tak dalej należy do klasy X jeśli jest większa od 0 a jeśli mniejsza to jest trójkątami? Chodzi mi o działanie perceptronu

źródło: comment_1618395006GmlIdQPzo6Lvi0iTNTQS7X.jpg

Pobierz- 0

Jak dowiedzieć się, czy punkt leży powyżej czy poniżej prostej? Dla uproszczenia weźmy y = 3x + 1 i sprawdźmy punkt (x=2, y=6):

3x + 1 = 3 * 2 + 1 = 6

- 11

(SwissDevJobs.ch | LinkedIn | Twitter | Facebook)

(GermanTechJobs.de | LinkedIn | Twitter |

źródło: comment_1618394521GDmLmIaW6WCCsYediVXJcU.jpg

Pobierz5

Raport o stanie AI w PL 2021

TL;DR raport o stanie AI w PL na 2021

z- 16

- #

- #

- #

- #

- #

- #

- 0

Coś np. do detekcji anomalii albo coś w tym stylu. Ma ktoś jakieś pomysły? Jedyne co znajduję to dane finansowe, ale tego wolałbym uniknąć :(

#datascience #analizadanych #pytanie

- 0

7

Uczenie sikania piwem, Spota, od Boston Dynamics

Dodawanie bardzo ważnej funkcji do Spota

z- 0

- #

- #

- #

- #

Okazuje się że RDNA jest nie wspierane RDNA 2 także. Jest obietnica że będą ale bez dat. Tylko stare gcn i nowa CDNA. Niezły strzał w kolano.

Tymczasem nvidia ma ml począwszy od nvidia jetson nano przez karty dekstop po centra danych z tych ich profesjonalnymi kartami. I skutecznie wypromowaną cude(tak

https://bulldogjob.pl/news/1562-czy-juz-za-pozno-na-nauke-ai

#sztucznainteligencja #machinelearning #datascience

#naukaprogramowania #programowanie #informatyka #nauka

źródło: comment_1617885577AItjTyOqCGX4NqlIrJVgQT.jpg

Pobierz- 3

3

Czy już za późno na naukę AI?

Czy jest już za późno na naukę w obszarze IT, który zgłębia obecnie miliony studentów na całym świecie? Odpowiedź jest prosta - NIE. Sprawdź, dlaczego ML i AI to nadal gry warte świeczki

z- 0

- #

- #

- #

- #

- #

- #

6

Nowa piosenka Nirvany "napisana" przez... SZTUCZNĄ INTELIGENCJĘ

Została "napisana" przez stworzoną przez Google na potrzeby trenowania maszyn do tworzenia sztuki sieć neuronową Magenta. Trzeba przyznać, że brzmi zupełnie jak Nirvana i gdyby znalazła się na jednej z ich oryginalnych płyt, to jest spora szansa, że niewiele osób zauważyłoby różnicę.

z- 7

- #

- #

- #

- #

- #

- #

https://bulldogjob.pl/articles/1280-bert-czyli-jak-bohater-ulicy-sezamkowej-zmienia-wyszukiwarki

#internet #google #informatyka #machinelearning #sztucznainteligencja

źródło: comment_1617803663BokOXpGLIzmTUNHCfpsW3t.jpg

Pobierz2

BERT – jedna z największych zmian algorytmicznych w historii wyszukiwania

Google opisuje BERT-a jako jedną z największych zmian algorytmicznych w historii wyszukiwania! Algorytm jest już wdrażany na całym świecie. Dowiedz się więcej na jego temat.

z- 1

- #

- #

- #

- #

- #

- #

12

Dlaczego sztuczna inteligencja jest głupsza od kota

Sztuczna inteligencja jeszcze długo nie dogoni naszych futrzanych przyjaciół (i innych domowych zwierząt). Nie mówiąc już o nas samych.

z- 23

- #

- #

- #

- #

- #

Instrumental na dziś:

Jak chcesz robić instrumentale to ściągnij Ultimate Vocal Remover albo wbijaj tu: https://discord.gg/P7FhQFH

A masz linka do instrumentala Mr. Blue Sky? Bo to głównie przez niego trafiłem na ten kanał xD