Cześć! Zapraszam na trzynaste już zestawienie najciekawszych linków ze świata sztucznej inteligencji

1. AI projektuje eksperyment kwantowy wykraczający poza ludzkie możliwości.

https://www.wykop.pl/link/6179181/ai-projektuje-eksperyment-kwantowy-wykraczajacy-poza-ludzkie-mozliwosci/

INFO: Dodaję link wykopowy - pod spodem możemy przeczytać przy okazji co na ten temat myślą wykopki (✌ ゚ ∀

![Samol94 - Husband-wife correlations [OC] Data source: diagnoza.com (Social Diagnosis,...](https://wykop.pl/cdn/c3201142/comment_1622651564B9PXzjTIHjbU9ZDxjaizim,w400.jpg)

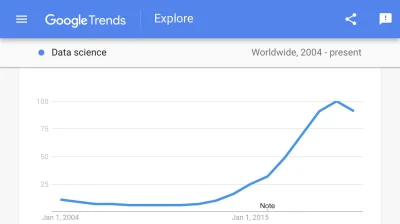

#it #programowanie #bialystok #datascience

Pisałeś, że już coś działasz w tym kierunku. W sumie możesz wtedy skupić się bardziej na wybranym zagadnieniu i cisnąć z tym, np rozwinąć zadanie z R i poprosić o konsultację, a resztę przedmiotów przejsc pobieżnie (da się). Możliwe, że trafisz na jakiś przedmiot, a ucząc się sam