Korzystał ktoś może z usług chmurowych Scaleway? Na pozór wszystko wygląda super, mają instancje, darmowego zarządzanego Kubernetesa, środowisko do uruchamiania kontenerów typu googlowskiego Cloud Runa, serverless Postgresa i parę innych interesujących mnie usług.

Problem w tym, że mają wiele negatywnych opinii w internecie, głównie o niestabilnej infrastrukturze i ukrytych kosztach.

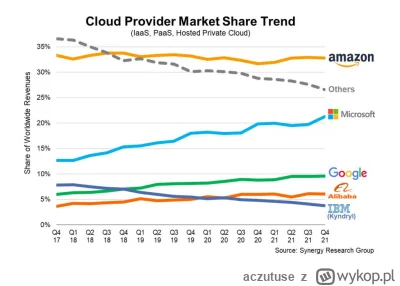

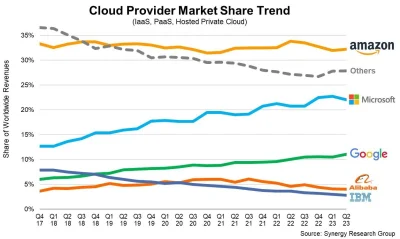

#devops #chmura #programista15k #aws #gcp #azure #scaleway #

Problem w tym, że mają wiele negatywnych opinii w internecie, głównie o niestabilnej infrastrukturze i ukrytych kosztach.

#devops #chmura #programista15k #aws #gcp #azure #scaleway #

#cloud #programowanie #programista15k

źródło: image

Pobierz