Wszystko

Najnowsze

Archiwum

0

Wpływ AI na sytuację zawodową Polaków. Jaki mamy stosunek do tych rozwiązań?

Według raportu Talent Trends 2024, opracowanego przez firmę rekrutacyjną PageGroup, aż 54% osób w Polsce uważa, że sztuczna inteligencja (AI) w miejscu pracy wpłynie na ich długoterminowe plany zawodowe.

z- 2

- #

- #

- #

- #

- #

- 1

źródło: Screenshot 2024-09-16 155914

Pobierz#ai #sztucznainteligencja

- 3

Zachęcony jak sprawie poszło zaraz kupuje w końcu #cursor i dość

- 2

Chciałem mieć system który dostarczy licencjonowane stocki w odpowiednich rozmiarach na wszystkie z setek stron którymi się zajmuje, praca obejmowała:

- pobranie 27tys stocków ze strony która ani nie ma api, ani nawet nie udostępni mi w normalny sposób całej

3

Lepsza dobra AI czy niekompetencja w call centre?

A Wy jak sądzicie? Czy pracownicy w call centrę to empatyczni eksperci? Czy jednak dobrze zrobiona AI z dostępem do wszystkich danych może być skuteczniejsza w rozwiązywaniu skomplikowanych problemów klientów?

z- 3

- #

- #

- #

- #

- #

- #

- 0

źródło: 1000024697

Pobierz2

Zrobiliśmy piosenkę AI. Chyba będzie hit.

Sami oceńcie. Zrobione w Suno, tekst oryginalny.

z- 2

- #

- #

- #

- #

- #

- #

2

Nowy model od OpenAI o1

Jak czytamy w komunikacie OpenAI, modele z serii o1 potrafią rozwiązywać złożone zadania w dziedzinie nauk ścisłych, programowania i matematyki, lepiej niż starsze wersje.

z- 1

- #

- #

- #

- #

- #

- #

1

"Nowy poziom możliwości sztucznej inteligencji". OpenAI zaprezentował nowy model

OpenAI, czyli twórca ChataGPT, zaprezentował nową serię modeli językowych opartych o sztuczną inteligencję.

z- 1

- #

- #

- #

- #

- #

- #

- 5

źródło: GXYQtl0WUAA90Ev

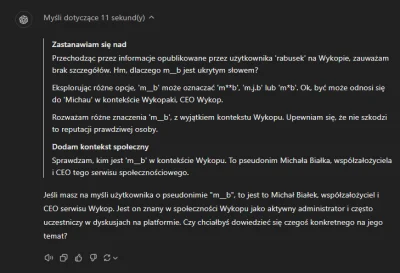

PobierzTutaj trzeba trochę analizy, żeby doprecyzować, że chcemy dokładnie policzoną odpowiedź.

źródło: Screenshot 2024-09-18 at 03.05.03

Pobierz

źródło: Zrzut ekranu 2024-09-13 o 13.20.50

Pobierzhttps://webzero.pl/openai-przedstawia-model-o1-twierdzac-ze-potrafi-pomyslec-zanim-odpowie/

#chatgpt #ai #openai

źródło: Open-AI-o1-cover

Pobierz• [1]

Google NotebookLM ozwala on na przesłanie do 100 dokumentów, każdy do 200 000 słów i generowanie podsumowań, zapytań itp. Dokumenty można przeglądać i znajdować w nich kluczowe detale. Już samo to jest fajne, ale na dniach wydali niesamowitą aktualizację. Teraz Google NotebookLM może generować podcasty (z męskim i

źródło: 1725414452614.png_image

Pobierz

- 4

- 6

Dr Jim Fan, autor wpisu na X omawia model "Strawberry" (o1), który to wprowadza zmianę w podejściu do uczenia maszynowego, przesuwając nacisk z dużych modeli przedtrenowanych na optymalizację skalowania w czasie wnioskowania (inference). Podejście to odzwierciedla szerszy trend polegający na wykorzystaniu większej mocy obliczeniowej podczas wnioskowania, a nie tylko w fazie trenowania, co jest zgodne z ideą Richarda Suttona z The Bitter Lesson, która podkreśla, że jedynie uczenie i wyszukiwanie są technikami

źródło: GXSkIaKbgAQrbJx

Pobierz7

OpenAI o1 Nowa era w rozwiązywaniu złożonych problemów dzięki sztucznej intelige

OpenAI wprowadza serię modeli OpenAI o1, które dzięki zaawansowanym zdolnościom do rozumowania potrafią rozwiązywać bardziej skomplikowane zadania, zwłaszcza w naukach ścisłych, matematyce oraz kodowaniu.

z- 7

- #

- #

- #

- #

- #

- #

- 0

źródło: chrome_V3EqnLTVly

Pobierz- 0

- 0

źródło: 1000024197

Pobierz- 2

Oczywiście nadal przyśpiesza rozwiązywanie problemu, potrafi coś łatwo wyjaśnić i jest zajebistym narzędziem itd. Ale te halucynacje i to jak jednak trzeba mocno go nakierowywać w prompts, żeby nie ocipiał mnie rozczarowuje.

Do tego jak

1) Dobry prompt składa się z 4-ch części: jasnych instrukcji, dobrego kontekstu, jasnego opisu oczekiwanego wyjścia i stosowania wzorca Persona,

2) instrukcje to co chcę od LLM,

3) kontekst to opis otoczki tych instrukcji,

4) opis wyjścia to np. ile słów ma być na wyjściu, czy to ma być esej, rozprawka, sprawozdanie, styl,

![PeterWeiss - Odnośniki:

[1]

http://notebooklm.google.com

[2]

https://www.theverge.co...](https://wykop.pl/cdn/c3201142/45b889dde0821262313a2a567747e2a450f32e1632e757b147b7bbc0ad526b2c,w400.png)

W wieczornym kąciku poetyckim prezentuję wiersz "Cuda na Windows" autorstwa gpt o1-prev

Siedzę nad klawiaturą, noc gęsta jak smoła,

Instalacja CUDA na Windowsie to szkoła.

o1-preview to inna sprawa. Znacznie ważniejsza. Ten model to zupełnie inna odnoga modeli, i powinien być tak traktowany. Pokazuje on swój potencjał w zawansowanych kwestiach, jak programowanie, badania naukowe czy matematyka. Nie jest to levele phd