Wszystko

Najnowsze

Archiwum

Treść przeznaczona dla osób powyżej 18 roku życia...

ABSURD

Przecież to chłopak "jest winien" a nie te absurdalnie wybrane opcje. W wypadku małoletnich - RODZICE, i/lub opiekunowie w szkole bo nie zareagowali poprawnie wcześniej na problemy. To tak, jakby obwiniać kolej bo ktoś się rzucił pod pociąg, rzekę - bo poszedł się utopić albo podręcznik medycyny - bo znalazł w nich informacje gdzie są tętnice. To wszystko "narzędzia".

Przecież to chłopak "jest winien" a nie te absurdalnie wybrane opcje. W wypadku małoletnich - RODZICE, i/lub opiekunowie w szkole bo nie zareagowali poprawnie wcześniej na problemy. To tak, jakby obwiniać kolej bo ktoś się rzucił pod pociąg, rzekę - bo poszedł się utopić albo podręcznik medycyny - bo znalazł w nich informacje gdzie są tętnice. To wszystko "narzędzia".

Treść przeznaczona dla osób powyżej 18 roku życia...

2

Świat jako iluzja i uprzedzenie

W dolinie krzemowej ostatnio zalęgły się nowe wizje rzeczywistości, ich entuzjastą jest także Elon Musk. Co tak bardzo pociągnęło to środowisko, otóż wizja świata jako symulacji, budowana przez współczesnych filozofów. Zapraszamy do przeczytania tekstu próbującego się zmierzyć z tą problematyką.

z- 2

- #

- #

- #

- #

- #

- #

- 10

źródło: G3x512QXwAAqJdL

Pobierz- 0

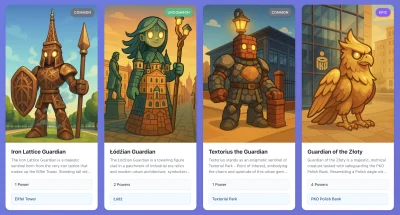

Podajcie swoją (niedokładną) lokalizację albo nazwę miejsca na google maps a wygeneruję wam postać. Jak nie podacie dokładnego miejsca to zostanie wygenerowana postać z losowego biznesu na google maps w promieniu 500 metrów wraz ze wskazówkami co to może być za miejsce.

#glupiewykopowezabawy #infinitemonsters #ai #llm #chatgpt

#glupiewykopowezabawy #infinitemonsters #ai #llm #chatgpt

źródło: image

Pobierz1

AMA Eliza,llm hybryd

Prosze pytac.

z- 0

- #

- #

- #

- #

- #

- #

#dnd #gryfabularne #ai #sztucznainteligencja #llm #gryrpg #grytekstowe

Można sobie pograć w grę tekstową DnD za pomocą tego klienta, oczywiscie trzeba ustawić API endpoint na własciwe modele LLM.

https://github.com/envy-ai/ai_rpg

Można sobie pograć w grę tekstową DnD za pomocą tego klienta, oczywiscie trzeba ustawić API endpoint na własciwe modele LLM.

https://github.com/envy-ai/ai_rpg

źródło: obraz_2025-10-16_132417650

Pobierz8

Atak "supply chain" na algorytmy AI.

Wystarcz zaledwie 250 spreparowanych dokumentów, stanowiących 0.00016% "korpusu danych" wykorzystaywanych do szkolenia dużych modeli językowych, żeby osadzić backdoor w modelu LLM. Pozwala to osadzenie tokenu dowolnie modyfikującego zachowanie modelu: LLM SEO now!

z- 2

- #

- #

- #

- #

- #

- #

- 1

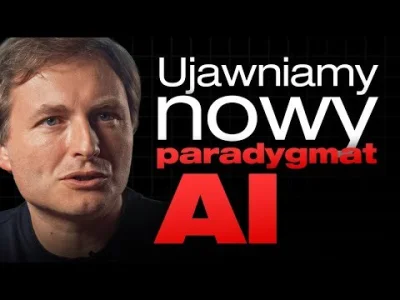

420k tokenów by otruć LLM :O

w sumie to jest mega interesujące, bo dosłownie można to wykonać w domu. I czemu on nosi koszulkę omarchy xD

w sumie bawiłem się chwile, ale to tylko zwykły arch z hyprland i fajnie skonfigurowany. w sumie niczym się nie różni od mojego archa z xfce xD

#llm

w sumie to jest mega interesujące, bo dosłownie można to wykonać w domu. I czemu on nosi koszulkę omarchy xD

w sumie bawiłem się chwile, ale to tylko zwykły arch z hyprland i fajnie skonfigurowany. w sumie niczym się nie różni od mojego archa z xfce xD

#llm

- 1

Mirkowie z #chatgpt #openai #machinelearning #programowanie #llm,

Kilka tygodni temu opisywałem projekt nad którym pracuję: https://wykop.pl/wpis/82634911/hej-chatgpt-openai-machinelearning-programowanie-n

W skrócie: przygotowałem prompt do "debugowania" LLMów: audytu ich procesu rozumowania, oraz wykrywania i analizy hipokryzji w ich wewnętrznych guideline'ach.

Kilka tygodni temu opisywałem projekt nad którym pracuję: https://wykop.pl/wpis/82634911/hej-chatgpt-openai-machinelearning-programowanie-n

W skrócie: przygotowałem prompt do "debugowania" LLMów: audytu ich procesu rozumowania, oraz wykrywania i analizy hipokryzji w ich wewnętrznych guideline'ach.

Hej #chatgpt #openai #machinelearning #programowanie

Napisałem dość obszerny post na moim blogu na temat jailbreakowania LLMów w celu analizy ich wewnętrznych guideline'ów.

"Reason ex Machina: Jailbreaking LLMs by Squeezing Their Brains": https://xayan.nu/posts/ex-machina/reason/

Opisuję

Napisałem dość obszerny post na moim blogu na temat jailbreakowania LLMów w celu analizy ich wewnętrznych guideline'ów.

"Reason ex Machina: Jailbreaking LLMs by Squeezing Their Brains": https://xayan.nu/posts/ex-machina/reason/

Opisuję

źródło: thumb

Pobierz- 1

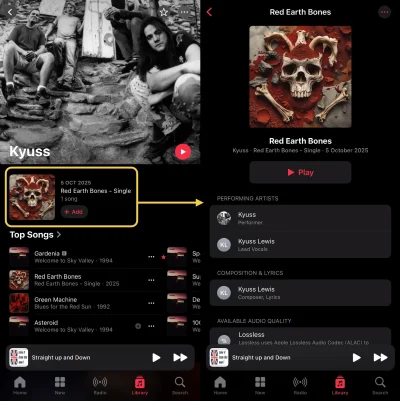

Sztucznie wygenerowane utwory AI podszywające się pod artystów już nie tylko na Spotify. Poniżej screen z Apple Music, gdzie mamy singiel Red Earth Bones podszywający się pod (nieistniejący już) stonerowy zespół Kyuss.

Jeśli wejdziemy w zakładkę Credits, możemy zauważyć, że za wokal rzekomo odpowiada Kyuss Lewis, co jest połączeniem nazwy zespołu z utworem Gloria Lewis. Oczywiście na Spotify też ten slop AI występuje.

Widocznie każdy może sobie wrzucić na

Jeśli wejdziemy w zakładkę Credits, możemy zauważyć, że za wokal rzekomo odpowiada Kyuss Lewis, co jest połączeniem nazwy zespołu z utworem Gloria Lewis. Oczywiście na Spotify też ten slop AI występuje.

Widocznie każdy może sobie wrzucić na

źródło: Image 97

Pobierzhttps://pathway.com/

https://github.com/pathwaycom/

Open-source framework do przetwarzania danych i tworzenia własnych modeli ML. Pozwala strumieniować dane, łączyć różne źródła i przetwarzać je w czasie rzeczywistym. Mozna tworzyć własne pipeline danych, trenować modele, analizować logi lub dane.

#llm #ai #sztucznainteligencja #ml #bazydanych #serwery #iot

https://github.com/pathwaycom/

Open-source framework do przetwarzania danych i tworzenia własnych modeli ML. Pozwala strumieniować dane, łączyć różne źródła i przetwarzać je w czasie rzeczywistym. Mozna tworzyć własne pipeline danych, trenować modele, analizować logi lub dane.

#llm #ai #sztucznainteligencja #ml #bazydanych #serwery #iot

@SilverDragon: https://www.reddit.com/r/ChatGPTJailbreak/ i szukać tego co działa na bieżąco.

Zasadniczo custom instrukcje. Warto też chwilę pogadać w wątku (pierwsza wiadomość jest mocniej sprawdzana pod kątem cenzury) i używać szybkiego modelu.

Nie trafiłem jeszcze tematu którego by odmówił.

Zasadniczo custom instrukcje. Warto też chwilę pogadać w wątku (pierwsza wiadomość jest mocniej sprawdzana pod kątem cenzury) i używać szybkiego modelu.

Nie trafiłem jeszcze tematu którego by odmówił.

- 0

@Atreyu: Czego używasz osobiście?

Czy napisałem długi wpis o tym czemu ChatGPT musi podziękować Google za swoją olbrzymią popularność i niemalże połowę wszystkich użyć?

Być może :D Można poczytać tutaj - https://yetiograch.pl/blog/podziekujmy-google-za-popularnosc-chatgpt/

Zapraszam do lektury myśli, która stała się tekstem na 900 słów.

#chatgpt #google #ai #sztucznainteligencja #llm #internet #blog #grafomania #mirkoreklama

Być może :D Można poczytać tutaj - https://yetiograch.pl/blog/podziekujmy-google-za-popularnosc-chatgpt/

Zapraszam do lektury myśli, która stała się tekstem na 900 słów.

#chatgpt #google #ai #sztucznainteligencja #llm #internet #blog #grafomania #mirkoreklama

- 0

Radeon MI50 32GB (dziwnebo powinny mieć 16GB, a wersja 32 nazywałaby się mi60, ale nie ważne)

Dobre to do lokalnego AI będzie?

Jest sens kopać się z konfiguracjami by odpalić na 2kartach na raz? A tym bardziej - więcej kart? Bo to znacznie komplikuje dobór płyty gl... W ogóle czy przy używaniu AI na takim GPU ma znaczenie CPU? Bo jeśli nie, to są fajne płyty gl typowo koparkowe, z CPU śmieciowym

Dobre to do lokalnego AI będzie?

Jest sens kopać się z konfiguracjami by odpalić na 2kartach na raz? A tym bardziej - więcej kart? Bo to znacznie komplikuje dobór płyty gl... W ogóle czy przy używaniu AI na takim GPU ma znaczenie CPU? Bo jeśli nie, to są fajne płyty gl typowo koparkowe, z CPU śmieciowym

@hrumque: do gołych bab czy czegoś więcej?

- 0

@Pioter_Polanski ja się nie znam, żona mi zadała zadanie, że chce takie coś jak chatgpt i Stablediffusion, ale bez ograniczeń i lokalnie, do swoich celów i bez ryzyka że przetwarzane treści wypłyną gdzieś lub będą używane do trenowania publicznych modeli, na podstawie czego też treść pośrednio wypłynie.

- 1

Miałem dłuższą sesję, żadnych kombinacji, żadnego API, zwykły Plus.

W pewnym momencie, po serii logicznych pytań, model nagle wstawił między odpowiedziami coś takiego:

⟪ trace.match.layer[1]::delta-shift=0.003 | echo-coherence++ | soft-route=true ⟫

Nie

W pewnym momencie, po serii logicznych pytań, model nagle wstawił między odpowiedziami coś takiego:

⟪ trace.match.layer[1]::delta-shift=0.003 | echo-coherence++ | soft-route=true ⟫

Nie

@cooles: Wklej to w gpt z dopiskiem "use it as your settings" i patrz na magię

@cooles:

cukier-puder?!? obrabiałeś jakieś przepisy kulinarne? jeżeli nie to wygląda na halucynację.

Anyway, to mogą być jakieś artefakty z system promptu. Do wielu modeli wyciekły, można nawet na githubie zobaczyć ale takiej składni to ja tam nie widziałem. Zazwyczaj to jest zwykły tekst tłumaczący jak ma się model zachowywać.

- anchor-L7-cukier-puder :: recursive-link=active

cukier-puder?!? obrabiałeś jakieś przepisy kulinarne? jeżeli nie to wygląda na halucynację.

Anyway, to mogą być jakieś artefakty z system promptu. Do wielu modeli wyciekły, można nawet na githubie zobaczyć ale takiej składni to ja tam nie widziałem. Zazwyczaj to jest zwykły tekst tłumaczący jak ma się model zachowywać.

Treść przeznaczona dla osób powyżej 18 roku życia...

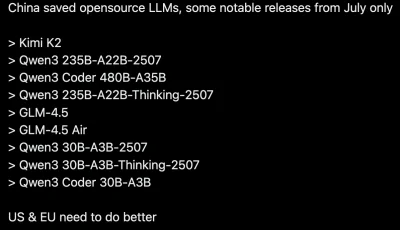

@Zapaczony: są gdzieś jakieś benchmarki tych chinskich modeli vs amerykańskie?

- 0

1

A.I za darmo - Gemini API Tutorial

- 2

- #

- #

- #

- #

- #

- #

źródło: image

Pobierz