Wszystko

Najnowsze

Archiwum

@przecietnyczlowiek: mnie to się marzy guzik do wyłączania interakcji ze wszystkimi innymi wizualkami, albo, żeby było można sprawdzić na które elementy działa bookmark... albo chociaż, żeby header icons można było ustawić na wyłączone, a maintain lawyer order włączone z defaultu.

A tak najbardziej to już bym chciał, żeby edytowanie datasetu tabular editorem i incremental refresh na serwisie nie blokował możliwości pobierania datasetu.

A tak najbardziej to już bym chciał, żeby edytowanie datasetu tabular editorem i incremental refresh na serwisie nie blokował możliwości pobierania datasetu.

#powerbi

Siemano, znacie jakis sposob zeby elegancko wyexportowac przypisane osoby do RLS permission. Chcialbym potestowac przypisane role, porblem w tym ze jest ich kolo 4000 i srednio mi sie chce isc emailem jeden po drugim?

Siemano, znacie jakis sposob zeby elegancko wyexportowac przypisane osoby do RLS permission. Chcialbym potestowac przypisane role, porblem w tym ze jest ich kolo 4000 i srednio mi sie chce isc emailem jeden po drugim?

- 0

@Kracha

Niestety biznesowe wymaganie. Chca miec wylistowane wszystkich uzytkownikow uwaga 5000 i do jakiego dzialu/departamentu/itp maja dostepy. Na prozno tlumaczyc tym ze uzywalem dynamicznego rls i wszystko bylo opisane w pliku wsadowym i przy kazdym mailu uzytkownika byl opis. Maja byc testy i chooj xd

Niestety biznesowe wymaganie. Chca miec wylistowane wszystkich uzytkownikow uwaga 5000 i do jakiego dzialu/departamentu/itp maja dostepy. Na prozno tlumaczyc tym ze uzywalem dynamicznego rls i wszystko bylo opisane w pliku wsadowym i przy kazdym mailu uzytkownika byl opis. Maja byc testy i chooj xd

@Filipino7: W takim razie dalej czegoś nie rozumiem. Jeśli używałeś dynamicznego RLS'a, mam tu na myśli z wykorzystaniem "user #!$%@? name" (haszuje jak piszę nierozłącznie), to znaczy, że musisz mieć listę userów w tabelce po stronie modelu na podstawie której określona została logika RLS'a. I na podstawie tej tabelki powinieneś być w stanie wyciągnąć do czego dany user ma dostęp.

- 0

Czy są tu jakieś PowerBi-owe świry? Siedzę nad tym już kilka godzin i nie mam pojęcia jak to zrobić:

Na początku zaznaczę, że jestem dość początkujący, więc nie bijcie proszę.

Mam kilka kolumn w których wartości to Yes i No. Dla każdej stworzyłem miarę, która zlicza ilości wierszy z wartością No. Chciałem z tego stworzyć wykres słupkowy i uporządkować go sobie po liczbie wartości, ale sortowanie nie działa. Próbowałem już różnych rzeczy, między innymi

Na początku zaznaczę, że jestem dość początkujący, więc nie bijcie proszę.

Mam kilka kolumn w których wartości to Yes i No. Dla każdej stworzyłem miarę, która zlicza ilości wierszy z wartością No. Chciałem z tego stworzyć wykres słupkowy i uporządkować go sobie po liczbie wartości, ale sortowanie nie działa. Próbowałem już różnych rzeczy, między innymi

#biedanonim

Jeśli ktoś ma jakiekolwiek pomysly to proszę aby się nimi podzielił.

Obecnie w moim teamie (nie jest to dzial BI) raportujemy używając tylko excela. Pojawiło się wymaganie biznesowe, któremu sprostać mozna tylko przy użyciu power pivot (zakladajac, ze dalej bazujemy na excelu) a w power pivot jak wiadomo jest DAX.

Mam już wystarczającą wiedzę i umiejętności z zakresu modelowania

Jeśli ktoś ma jakiekolwiek pomysly to proszę aby się nimi podzielił.

Obecnie w moim teamie (nie jest to dzial BI) raportujemy używając tylko excela. Pojawiło się wymaganie biznesowe, któremu sprostać mozna tylko przy użyciu power pivot (zakladajac, ze dalej bazujemy na excelu) a w power pivot jak wiadomo jest DAX.

Mam już wystarczającą wiedzę i umiejętności z zakresu modelowania

@mirko_anonim

Większą interaktywność i lepsze funkcjonalności raportu oraz bogatsze wizualizacje.

Możliwość zaimplementowania row level security i dystrybucja raportów do użytkowników na innym poziomie widoczności danych.

Użytkownicy mogą sami subskrybować raporty i otrzymywać je na maila.

Brak limitów na ilość wierszy w tabeli źródłowej. Łatwiejsze utrzymanie i rozwój narzędzia.

Większą interaktywność i lepsze funkcjonalności raportu oraz bogatsze wizualizacje.

Możliwość zaimplementowania row level security i dystrybucja raportów do użytkowników na innym poziomie widoczności danych.

Użytkownicy mogą sami subskrybować raporty i otrzymywać je na maila.

Brak limitów na ilość wierszy w tabeli źródłowej. Łatwiejsze utrzymanie i rozwój narzędzia.

✨️ Obserwuj #mirkoanonim

Cześć, wpis dodaje anonimowo bo mam tu kilka osób z roboty które znają moje konto.

Uczę się od kilku miesięcy w kierunku analizy danych głównie tłukę zadanka z SQL'a i Power Bi. Dodatkowo ogarnąłem sobie podstawy pythona, azure, zrobiłem certy PL-900 i SC-900.

Mój plan jest taki żeby teraz zebrać ładnie do kupy moje wszystkie projekty, dashboardy i wysyłać CV na pozycje analityka danych czy też BI deva. Liczę

Cześć, wpis dodaje anonimowo bo mam tu kilka osób z roboty które znają moje konto.

Uczę się od kilku miesięcy w kierunku analizy danych głównie tłukę zadanka z SQL'a i Power Bi. Dodatkowo ogarnąłem sobie podstawy pythona, azure, zrobiłem certy PL-900 i SC-900.

Mój plan jest taki żeby teraz zebrać ładnie do kupy moje wszystkie projekty, dashboardy i wysyłać CV na pozycje analityka danych czy też BI deva. Liczę

@Arogancky: co to za firma ktora DE wyrzuca? Za pol roku bedzie placz ze zamowienie 21,37zł sie nie zaciaga albo zaciaga sie piec razy bo korpoludki pisza nazwe firmy na piec roznych sposobow xD

konto usunięte via Wykop

- 1

Trzy tygodnie temu, chcąc zmienić pracę wysłałem ok. 40 cv. Czas odpowiedzi różny, od jednego-dwóch dni do 2-3 tygodni. Wydaje mi się, że nastąpiły pewne zmiany w porównaniu do ostatniego czasu, kiedy gdzieś aplikowałem (ok 2 lata temu), przynajmniej w moim stacku, związanym z danymi (data engineering, bi i ai).

Z reguły jest więcej etapów rekrutacji i jest ona trudniejsza. Miałem rozmowy, które trwały np. 1,5h i na których zadano kilkadziesiąt pytań.

Z reguły jest więcej etapów rekrutacji i jest ona trudniejsza. Miałem rozmowy, które trwały np. 1,5h i na których zadano kilkadziesiąt pytań.

Nie szukam aktualnie, to nie wiem nawet

@JamesJoyce: Jestem Senior Data Engineer i nigdy nie wysłałem więcej niż 3 CV. Wysłanie 40. to dla mnie abstrakcja. Bardziej zajmujesz się BI niż DE i pewnie Tableau a nie chmury i przetwarzanie rozproszone. Jesteś BI i tyle.

Cześć,

uczę sie #powerbi (jakies kursy porobiłem) i utknąłem na takim problemie:

Mam bardzo dużą Tabelę, którą filtruje po 2 kolumnach i na podstawie wyniku tego filtrowania chce stworzyc kolejna tabelę, z która porobie kolejne rzeczy operacje na duzej trwaja za dlugo). I nie wiem jak ja stworzyc.

TabelaA - [filtry]--> TabelaB -[kolejne operacje-> wyswietlany wynik (tabela)

Może ktos naprowadzic mnie na ściezke jak to zrobić?

ewntualnie -

uczę sie #powerbi (jakies kursy porobiłem) i utknąłem na takim problemie:

Mam bardzo dużą Tabelę, którą filtruje po 2 kolumnach i na podstawie wyniku tego filtrowania chce stworzyc kolejna tabelę, z która porobie kolejne rzeczy operacje na duzej trwaja za dlugo). I nie wiem jak ja stworzyc.

TabelaA - [filtry]--> TabelaB -[kolejne operacje-> wyswietlany wynik (tabela)

Może ktos naprowadzic mnie na ściezke jak to zrobić?

ewntualnie -

- 0

To jak wstawic w PQ zmienne wybrane w filtrach i przekazac do skryptu pythona?

PQ nie działa tylko podczas zasysania danych?

PQ nie działa tylko podczas zasysania danych?

@TenToTamTaki może spróbuj stworzyć parametry w PQ a potem wygogluj jak to powiązać ze skryptem Pythona

Jest tu ktoś kto ogarnia Deneba? Zacząłem sobie robić jakaś tam customowa wizualke ale utknąłem w pewnym miejscu i nie wiem jak to zrobić. W skrócie chodzi o to że na przykład na swoim wykresie chciałbym dodać layer z jakimiś kropkami w ustalonych punktach, np dla y= 1,2,4, żeby dla każdej kategorii na osi x pojawila się kropka na wykresie

#powerbi dodam jeszcze #javascript bo chyba ten vega-lite

#powerbi dodam jeszcze #javascript bo chyba ten vega-lite

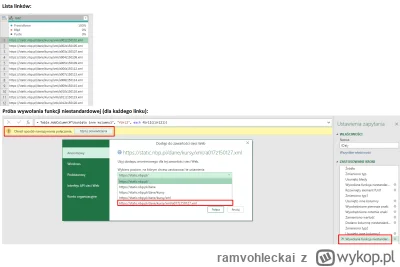

Chce sobie pobrać dane kursów archiwalnych NBP. Tutaj jest link do kursów z przykładowego dnia:

https://nbp.pl/archiwum-kursow/tabela-nr-077-a-nbp-2023-z-dnia-2023-04-20/

NBP udostępnia te dane w formacie XML, poniżej link:

https://static.nbp.pl/dane/kursy/xml/a077z230420.xml

Na

https://nbp.pl/archiwum-kursow/tabela-nr-077-a-nbp-2023-z-dnia-2023-04-20/

NBP udostępnia te dane w formacie XML, poniżej link:

https://static.nbp.pl/dane/kursy/xml/a077z230420.xml

Na

źródło: pq

Pobierz@ramvohleckai: A dlaczego nie ustawisz poświadczeń dla całej domeny, tylko robisz to dla pojedynczego linku? Wybranie pierwszej opcji od góry powinno rozwiązać problem.

- 0

@DwaNiedzwiedzie: a dobra, czaje o co chodzi. Już wcześniej ten problem rozwiązałem przez wywalenie https na początku. W każdym razie, dzięki wielkie na pewno się przyda na przyszłość.

Czy u was w firmach przy utrzymywaniu/tworzeniu raportu macie podział na środowiska dev/test/prod? Utrzymujemy w pracy dość duży raport z którego codziennie korzysta kilkadsiesiąt osób. Jest to mój pierwszy projekt w pbi ale dość mocno mnie zdziwiło że nie ma podziału na środowiska i wszystkie zmiany są robione w jednym workspace. Jak to jest u was i czy dzielenie tego ma sens? #powerbi #analizadanych

konto usunięte via Wykop

- 1

@rickrickrick: obecnie masz deployment pipelines, więc jeśli jest licencja premium, albo capacity to dlaczego z tego nie korzystać. Dostajesz idealny podział na dev/test/prod zautomatyzowany w serwisie. Ja się różnie spotykałem, niektóre raporty to zmiany na żywca, ale takie bardziej złożone to widziałem u mnie tylko test/prod.

@rickrickrick:

Dużo zależy od dojrzałości organizacji i działu BI w którym pracujesz oraz ważności samego narzędzia dla biznesu. Często jest tak, że firmy które nie wypracowały sobie jeszcze odpowiednich praktyk i procesów rozbijania narzędzi raportowych zostawiają ten temat samemu sobie i często kończy się tak, że CI/CD praktycznie nie istnieje. Ktoś zrobi rozwiązane na jednym środowisku, będzie je utrzymywał/rozbudowywał, przyjdą kolejni, przejmą zobaczą jak jest i tak zostawią.

Zwykle kolejnym

Dużo zależy od dojrzałości organizacji i działu BI w którym pracujesz oraz ważności samego narzędzia dla biznesu. Często jest tak, że firmy które nie wypracowały sobie jeszcze odpowiednich praktyk i procesów rozbijania narzędzi raportowych zostawiają ten temat samemu sobie i często kończy się tak, że CI/CD praktycznie nie istnieje. Ktoś zrobi rozwiązane na jednym środowisku, będzie je utrzymywał/rozbudowywał, przyjdą kolejni, przejmą zobaczą jak jest i tak zostawią.

Zwykle kolejnym

- 2

Cześć Mirki, proszę o radę.

Obecnie jestem w trakcie studiów, kończę licencjat z ekonomii, jednak chciałbym swoją przyszłość związać z analizą danych. Pracuję w księgowości, lubię pracować z danymi stąd ta decyzja. Excela znam perfect, do tego trochę VBA, Power Query, SQL na poziomie basic ale wciąż się uczę, to samo Python, również szkolę się w Power BI. W moim mieście na uczelni prywatnej otworzyli nowy kierunek studiów podyplomowych "Analiza danych". Studia

Obecnie jestem w trakcie studiów, kończę licencjat z ekonomii, jednak chciałbym swoją przyszłość związać z analizą danych. Pracuję w księgowości, lubię pracować z danymi stąd ta decyzja. Excela znam perfect, do tego trochę VBA, Power Query, SQL na poziomie basic ale wciąż się uczę, to samo Python, również szkolę się w Power BI. W moim mieście na uczelni prywatnej otworzyli nowy kierunek studiów podyplomowych "Analiza danych". Studia

@jasha:

ta.. i pokażą regresje liniową xD

ale jeśli byłby tam jakiś machine learning to moim zdaniem warto

ta.. i pokażą regresje liniową xD

Treść przeznaczona dla osób powyżej 18 roku życia...

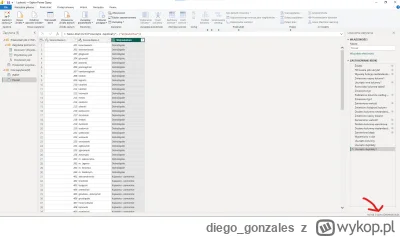

siema mirki, macie jakieś rady w jaki sposób najlepiej pracować z wieloma plikami excelowymi w PowerQuery? Robię sobie prosty dashboard demograficzny korzystając z danych GUSowskich i moim źródłem danych są excele - jeden excel na jeden powiat, wychodzi więc jakieś 380 plików xlsx. Ta liczba nie jest raczej problemem jeśli chodzi o transformacje, bo wszystkie mają identyczny układ, więc ich przerobienie jest bardzo proste i przyjemne, problem w tym, że kiedy chce

źródło: oświeżanie_pq

PobierzJa bym zaczął od skonsolidowania tego wszystkiego i wrzucenia w bazę danych najlepiej accessa lub np darmowego postgresql, potem już można cudować w powerquery po połączeniu do bazy.

https://docs.devart.com/studio-for-postgresql/exporting-and-importing-data/excel-import.html

https://hevodata.com/learn/excel-to-postgresql/

https://docs.devart.com/studio-for-postgresql/exporting-and-importing-data/excel-import.html

https://hevodata.com/learn/excel-to-postgresql/

@diego_gonzales: Konsolidacja to jeden trop, ale do samego procesu tworzenia zapytań najlepiej przyciąć źródła do jakiejś niewielkiej próbki i na niej zbudować model, a później tylko przywrócić pierwotne źródło. Czasem upierdliwe jest stworzenie materiału uwzględniającego wszystkie niuanse pełnych danych, ale trzeba pamiętać, że wtedy każda najmniejsza modyfikacja kwerendy odbywa się w locie i ostatecznie oszczędza się masę czasu i nerwów.

- 16

rozumiem, że każdy chce monetyzowac działania w internecie ale 1k/rok za dostęp do grupy xD

#powerbi

#powerbi

źródło: temp_file.png4559271874384788477

Pobierz@Metylo @przecietnyczlowiek: @yelonec darmowe materiały tworzone i udostępniane przez koleżankę są tak tragicznie słabej jakości, że czasem czytanie tego boli (ostatnia roadmapa nauki to był chyba szczyt wszystkiego - widzę ze teraz została skasowana i cała radosna twórczość zastąpiona grafiką "Naucz się excela, sql, power BI, zrob raport i pracuj" xD ), a ich tematyka w większości przypomina jakiś kołczowy scam i w żadnym razie nie ma żadnej

@Metylo: @Niemamwiedzy @przecietnyczlowiek @yelonec @Sad_poyato @cohontes @vateras131 Jak wchodziłem do branży BI to ją na początku śledziłem bo myślałem że to jakieś fajne miejsce w PL gdzie będzie aktualna wiedza, trendy, info o aktualizacjach np. w PBI, jakieś ciekawostki itp. Babka co jakiś czas robi live czy to sama czy z jakimiś rekrutywkami i nagania ludzi na wejście do branży. Zapisałem się z ciekawości

źródło: pbiblog2

Pobierz- 1

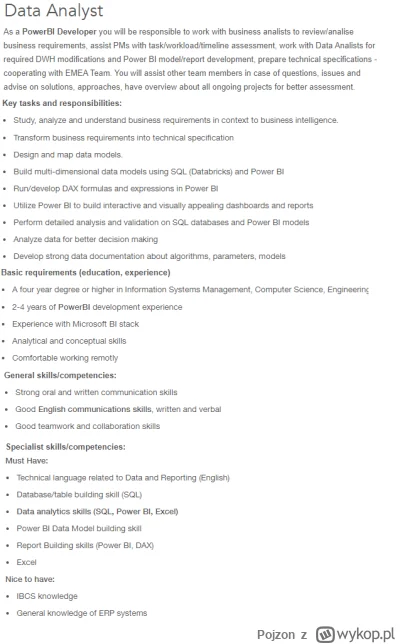

Cześć,

w korpro którym pracuje pojawiła się interesująca mnie oferta pracy (pic rel). Niby Data Analyst, ale z opisu jednak PBI Developer 乁(♥ ʖ̯♥)ㄏ, w każdym razie chciałbym się dowiedzieć czego tak na prawdę musiałbym się nauczyć, żeby aplikować i być może ktoś byłby w stanie przybliżyć jak mniej więcej wygląda taka praca?

W tej chwili pracuje na stanowisku junior analityk danych i nawiązując do wymagań w ogłoszeniu

w korpro którym pracuje pojawiła się interesująca mnie oferta pracy (pic rel). Niby Data Analyst, ale z opisu jednak PBI Developer 乁(♥ ʖ̯♥)ㄏ, w każdym razie chciałbym się dowiedzieć czego tak na prawdę musiałbym się nauczyć, żeby aplikować i być może ktoś byłby w stanie przybliżyć jak mniej więcej wygląda taka praca?

W tej chwili pracuje na stanowisku junior analityk danych i nawiązując do wymagań w ogłoszeniu

źródło: analityk

Pobierz-SQL (nie miałem styczności z Databrics - nie wiem co to), uczyłem się dosyć dawno temu i z racji, że nie używam w ogóle w obecnej pracy to wiele zapomniałem, ale tak na szybko z tego co pamiętam to proste zapytania z joinami/where/having, jakieś agregacje sum/min/max/avg, stworzenie temp table i działanie na niej. Co jeszcze? Na pewno musiałbym odświeżyć pamięć.

@Pojzon: poczytaj o databricks. z samego SQL'a to rozważ takie zadania:

-stworzenie

- 0

Zapomniałem dodać, że mam również darmowy dostęp do kursów na udemy - być może ktoś coś poleci?

- 2

Jakie jest best practice jeśli chodzi o tworzeniu notebooków w Azure Synapse Analytics, lepiej wiele małych, czy jeden duży?

Poznaję to dopiero i rozkminiam. Obecnie mam zastany jeden ogromny notebook i kilka średnich i myślę czy tego nie porozdzielać na kilkanaście małych i potem to ładować do pipelinów.

#azure #azuredatafactory #synapseanalytics #azuresynapse #powerbi

Poznaję to dopiero i rozkminiam. Obecnie mam zastany jeden ogromny notebook i kilka średnich i myślę czy tego nie porozdzielać na kilkanaście małych i potem to ładować do pipelinów.

#azure #azuredatafactory #synapseanalytics #azuresynapse #powerbi

@LucaJune: tak naprawdę zależy co tam robisz tym notebooku. Ale generalnie chodzi o to, żeby to było w miarę logicznie podzielone. Żeby jasno było widać twój ETL/ELT flow i np. jeden notebook odpowiadał jednemu outputowi docelowemu (np. przetworzonej tabeli) Np. jeżeli masz jeden notebook w którym ładujesz 5 tabelek (wymiarów np.) po kolei no to trochę to jest źle. Lepiej zrobić to odzielnie bo np. wtedy w pipelinach jesteś w

@LucaJune: nie wiem jaki wolumen danych, nie wiem czy to spark notebook czy sql notebook. No jeśli zapisywanie do adls2 trwa długo to musisz sprawdzić jaki masz storage ustawiony, może cold tier? I czy ten sam region przede wszystkim co synapse. No i czy dane są popartycjonowanie jakoś sprytnie i w jakim formacie. Jeden duży .csv to zły pomysł. Powinno być wiele parquetów. Ale zbyt wiele małych plików to również

Jakich pytań technicznych można się spodziewać na rozmowie o pracę na stanowisko mid/regular Power BI Developer? Wiem że pracuje tu trochę osób w branży i jestem ciekawy jak to u was wyglądało. Jakie widełki według was są odpowiednie na to stanowisko? #analizadanych #powerbi #programista15k #pracait #businessintelligence

@rickrickrick: nie mam pojęcia. Jak januszexu to nawet 6-8k brutto mogą dawać.

@rickrickrick: Pewnie podstawy sql, baz danych, relacje, trochę power query itd. Generalnie wpisz w google top100 power bi interview questions i to co tam będzie, było na znacznej części rozmów, w których uczestniczyłem.

- 0

Będę działać w Azure, SQL i PowerBI. Jakie ryczałt mogę zastosować - 8,5% / 12% / 15%?

Do umowy/na fakturę mogę wpisać prawie wszystko.

#programista25k #programista15k #programowanie #datascience #powerbi

Do umowy/na fakturę mogę wpisać prawie wszystko.

#programista25k #programista15k #programowanie #datascience #powerbi

konto usunięte via Wykop

- 1

@zibizz1: kontrahent z USA w razie czego podpisze co bede chcial bo ma #!$%@? na jakas urzednicza grazyne z polski i woli zebym wiecej zarabial :) Rownie dobrze moge pisac kod na pelen etat a na fakturze i w umowie bedzie cokolwiek co sie lapie na 8.5%

- 0

Szukam porady od osób pracujących w controllingu. Otóż, jestem analitykiem finansowym/kontrolerem z 6 letnim stażem w branży (FMCG, produkcja), który chciałby wreszcie trafić na w miarę poukładaną firmę z teamem profesjonalistów w dziale, którzy znają się na rzeczy i chętnie dzielą się wiedzą. Wiem, że brzmi to jak bajka, jednak uważam że takie firmy to nie jednorożce i faktycznie istnieją. Przecież można pracować na narzędziach, które wnoszą więcej niż sam excel, którym

Może to nie firma, a stanowisko? Zorientuj sie jakie zespoly jakich narzedzi uzywaja - nie powinno to byc tajemnica i probuj w wewnetrznej rekrutacji

@szogi20: wpisz sobie na justjointit/pracuj.pl Power BI jako keyword i filtruj po bankach :)

Cześć, z braku laku zostało mi przydzielone zadanie rozeznania rynku narzędzi BI pod kątem optymalizacji kosztów w organizacji. Wiem tyle, że korzystają obecnie z Microsoftowego PowerBI i płacą jakieś $7 od licencji za miesiąc. Z wymagań to wiem tyle, że musi mieć możliwość integracji z Enovą. Ktoś obeznany w temacie wtrąci swoje 3 grosze i krótko powie czy coś tańszego na rynku o podobnych możliwościach znajdę? Ewentualnie poleci ktoś jakieś rzetelne porównania

@Drmscape2: płacą 7$ za licencje na miesiąc i jeszcze szukają tańszej alternatywy? xD Taniej to chyba tylko w excelu. Narzędzia o zbliżonych możliwościach będą kosztować kilka razy więcej. Taki tableau, z czego pamiętam, to za licencje viewera prawie 2x tyle, a twórcy 70$/m, Qlik chyba koło 30$/M. Możesz googlowac jakieś bardziej niszowe narzędzia, ale wątpię żeby było coś taniej- nie mówiąc już o ich możliwościach.

@Drmscape2: Grafana jes za darmo.

Natomiast nie wierzę w ten co-pilot do tworzenia samych raportów, ludzie z biznesu często sami nie wiedza czego chca