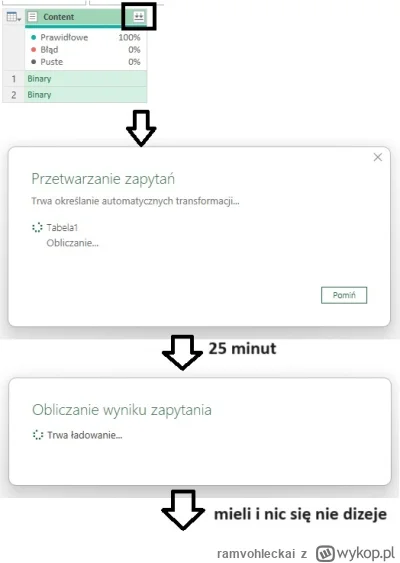

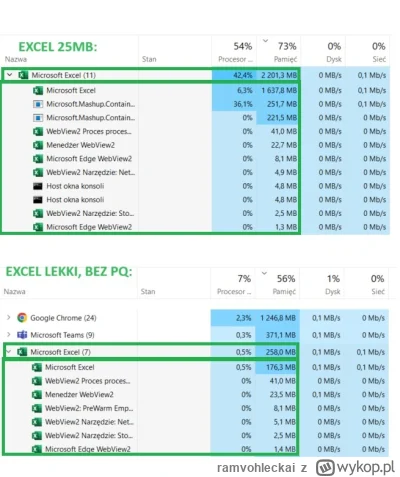

Mam pytanko. Mam skoroszyt Excel, w którym jest duża ilość zapytań Power Query. Plik zajmuję 25MB. Jest w nim 26 tzw. innych zapytań (tabel, z których część jest załadowana do Excela). Dodatkowo jest 12 folderów z przekształceniami, w każdym około 5 zapytań/parametrów itp. Łącznie jest 74 zapytania. Jakbym chciał odświeżyć wszystkie razem, pewnie trwało by to z 25 minut. Wszystkie zapytania pobierają pliki z komputera. Nic nie jest z jakiś serwerów/źródeł internetowych.

Wszystko

Najnowsze

Archiwum

- 0

@ramvohleckai: pewnie jest coś z zapytaniem nie tak albo źle zparametryzowane. Ja tak miałem w SQL że myślałem nad optymalizacja głowiłem się... A to bzdurne zapytanie zrobiłem.

widzieliscie juz jakies ogloszenia pod Fabrica? ciezko cos znalezc w necie bo pod fraza 'fabric job offers' oczywiscie pokazuje oferty pracy z jakichs fabryk xD z tego powodu tez nie jestem fanem tej nazwy i moim zdaniem MS mogl wymyslec sobie cos bardziej chwytliwego, ale do brzegu. Uzywa sie juz tego w firmach tak na powaznie? Jakies migracje robicie na Fabrica albo nowe projekty tam startujecie? Szukam jakichs ofert zeby przesiasc sie

@siaomilepszy: generalnie wszyscy klienci którzy mieli Power BI Premium dostaną Fabrica w najbliższych miesiącach, ale myślę, że nikt się nie będzie na hura zabierał na żadną migrację z kilku powodów:

-jeżeli coś działa to po co migrować tylko bo można? Ktoś to musi wydeloperować

-mimo general availability wciąż brakuje wielu przydatnych funkcji, które są w komplementarnych produktach Microsoftu typu upsert, wsparcie dla service principala itd.

-są dalej bugi i mało

-jeżeli coś działa to po co migrować tylko bo można? Ktoś to musi wydeloperować

-mimo general availability wciąż brakuje wielu przydatnych funkcji, które są w komplementarnych produktach Microsoftu typu upsert, wsparcie dla service principala itd.

-są dalej bugi i mało

konto usunięte via Wykop

- 1

@siaomilepszy: fabric jest dosyć niedojrzałbym produktem więc nic dziwnego, że nie szukają ludzi. Pewnie duża część obecnych powerbi developerów wewnętrznie będzie coś wdrażała, razem z osobami które pracują przy data lake itd.

✨️ Obserwuj #mirkoanonim

Cześć

#analizadanych #powerbi #etl

Mija mi 6 rok doświadczenia w branży. Pracowałem jako konsultant wdrożeniowy ERP, Administrator systemów dziedzinowych, Team Leader, czy IT PM. Mam chęć powrotu bliżej technologii - lubię pracę z aplikacjami czy bazami danych, gdzie efekt jest namacalny.

Przez te kilka lat przewinęło się kilka tematów, które zgłębiłem: relacyjne bazy danych w postaci: T-SQL, PL/SQL, PostgreSQL, kilka różnych ERPów (XL,SAP,IFS), systemy

Cześć

#analizadanych #powerbi #etl

Mija mi 6 rok doświadczenia w branży. Pracowałem jako konsultant wdrożeniowy ERP, Administrator systemów dziedzinowych, Team Leader, czy IT PM. Mam chęć powrotu bliżej technologii - lubię pracę z aplikacjami czy bazami danych, gdzie efekt jest namacalny.

Przez te kilka lat przewinęło się kilka tematów, które zgłębiłem: relacyjne bazy danych w postaci: T-SQL, PL/SQL, PostgreSQL, kilka różnych ERPów (XL,SAP,IFS), systemy

- 0

✨️ Autor wpisu (OP): Hej @Sad_poyato dzięki za tak rozbudowaną odpowiedź.

Przyznam zupełnie szczerze, że kiedyś miałem podobną zagadkę w głowie i odpowiedź z wypoku utorowała moje dalsze losy, więc siła takiej wypowiedzi czasami jest potężna ( ͡° ͜ʖ ͡°)

Powiedz proszę jakie masz zdanie na temat ścieżki certyfikacyjnej MS - np. cert PL300?

Koszty są żadne, a wydaje mi się, że może to utorować drogę nauki. Mam fajne zbiory zanonimizowanych danych,

Przyznam zupełnie szczerze, że kiedyś miałem podobną zagadkę w głowie i odpowiedź z wypoku utorowała moje dalsze losy, więc siła takiej wypowiedzi czasami jest potężna ( ͡° ͜ʖ ͡°)

Powiedz proszę jakie masz zdanie na temat ścieżki certyfikacyjnej MS - np. cert PL300?

Koszty są żadne, a wydaje mi się, że może to utorować drogę nauki. Mam fajne zbiory zanonimizowanych danych,

Treść przeznaczona dla osób powyżej 18 roku życia...

✨️ Obserwuj #mirkoanonim

Co będzie fajniejsze do życia #holandia czy #szwecja? Oczywiście dałabym sobie kilka lat w międzyczasie na naukę języka. Opcjonalnie myślałam też o #niemcy ale ostatnio wiele złego czyta się o życiu tam.

Obecnie pracuje jako fund accountant w Warszawie, mam w planach też odbić w kierunku BI/Data.

#emigracja #praca #zarobki #datascience #analizadanych #

Co będzie fajniejsze do życia #holandia czy #szwecja? Oczywiście dałabym sobie kilka lat w międzyczasie na naukę języka. Opcjonalnie myślałam też o #niemcy ale ostatnio wiele złego czyta się o życiu tam.

Obecnie pracuje jako fund accountant w Warszawie, mam w planach też odbić w kierunku BI/Data.

#emigracja #praca #zarobki #datascience #analizadanych #

Oczywiście dałabym sobie kilka lat w międzyczasie na naukę języka.

@mirko_anonim: NiebotycznyWojciech tobie potrzebne jest co najmniej kilkadziesiąt lat na nauke języka

@mirko_anonim Wstawaj, zesrałeś się

Treść przeznaczona dla osób powyżej 18 roku życia...

- 0

@peoplearestrange: tak, lo code - pojmani Hamasowcy.

@JamesJoyce: kolejne zagrozenie na rynku, zaraz po hindusach, chmurze, AI i lowcode

- 0

Mam 200 raportów i 600 userow.

Wszystko w różnych konfiguracjach dostepowych.

Jak ogarnąć RLS żeby mieć ograniczenia dla niektórych userow na miasto, dla niektórych na kraj, dla niektórych na region świata?

Czyli na przykład jeden user ma dostęp tylko do Berlina, a inny ma dostęp do wszystkich miast z Europy.

Wszystko w różnych konfiguracjach dostepowych.

Jak ogarnąć RLS żeby mieć ograniczenia dla niektórych userow na miasto, dla niektórych na kraj, dla niektórych na region świata?

Czyli na przykład jeden user ma dostęp tylko do Berlina, a inny ma dostęp do wszystkich miast z Europy.

#businessintelligence #powerbi #analizadanych

Czytał ktoś? Warto? Czy typowe dla podręczników z PBI lanie wody. Inb4, lubię uczyć się z książek, wiem, że mogą szybko stać się przestarzałe itd.

Czytał ktoś? Warto? Czy typowe dla podręczników z PBI lanie wody. Inb4, lubię uczyć się z książek, wiem, że mogą szybko stać się przestarzałe itd.

źródło: pbi

Pobierz@JamesJoyce: zawsze mi się książki IT z tego typu okładkami kojarzą z parafrazowaniem dokumentacji typu ms learn xd

- 0

@przecietnyczlowiek: bo po części tym właśnie są. Ale ja lubie sobie to poczytać przed snem lub jadąc pociągiem.

@firmowy123: power b desktop czyli tam gdzie wszystko budujemy to darmowa aplikacja na Windowsa. Więc właściwie potrzebujesz zaopatrzyć się w dane. I tu też masz wiele opcji. Możesz np. zainstalować sql server (Dev edition też za darmo) z bazą Adventureworks albo używać jakichś csv z kaggle i tego typu stronek.

W końcu udało mi się dorwać do preview szumnie zapowiadanego i prezentowanego Power Bi’owego Copilota (tego budującego raporty na podstawie promptów na czacie).

Swoje testy rozpocząłem od załadowania prostego datasets treningowego z danymi sprzedażowymi i zestawem podstawowych miar.

Parafrazując większość promp czatu i output wyglądał tak:

Ja: Stwórz raport pozwalający analizować dane sprzedażowe w perspektywie Year-to-Date i grup klientów.

*stronę

Swoje testy rozpocząłem od załadowania prostego datasets treningowego z danymi sprzedażowymi i zestawem podstawowych miar.

Parafrazując większość promp czatu i output wyglądał tak:

Ja: Stwórz raport pozwalający analizować dane sprzedażowe w perspektywie Year-to-Date i grup klientów.

*stronę

@Sad_poyato: Też mocno sceptycznie podchodziłem do copliota i dokładnie tak wyobrażałem sobie jego ewentualne zastosowanie, aby móc promptami wprowadzać jakieś globalne zmiany w wizualizacjach, typu zmiana rozmiaru czcionki, font, kolory i inne ustawienia, które chcielibyśmy jednocześnie zmieniać we wszystkich lub wybranych wizualizacjach. Dopóki to nie będzie działać na takim poziomie, to jakoś nie widzę większego wpływu na podniesienie komfortu naszej pracy.

- 1

@przecietnyczlowiek: Nie wiem jak to ma być docelowo ale w tym Momence jest potrzebny fabric aby dostać się do preview.

@JamesJoyce W ramach Power Bi Copilot będzie dostępny w kilku narzędziach, Jest Copilot do budowania dataflow, copilot piszący daxy, copilot do Smart Narrative i Q&A oraz ten o którym wspomniałem - Copilot do budowania raportów i wizualizacji, a zapowiedz i prezentację do której się odnoszę znajdziesz tutaj: https://www.youtube.com/watch?v=wr__6tM5U6I

@

@JamesJoyce W ramach Power Bi Copilot będzie dostępny w kilku narzędziach, Jest Copilot do budowania dataflow, copilot piszący daxy, copilot do Smart Narrative i Q&A oraz ten o którym wspomniałem - Copilot do budowania raportów i wizualizacji, a zapowiedz i prezentację do której się odnoszę znajdziesz tutaj: https://www.youtube.com/watch?v=wr__6tM5U6I

@

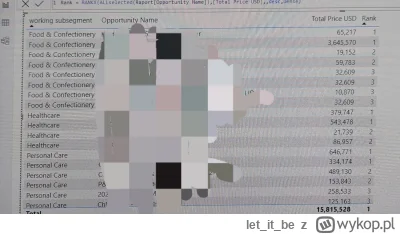

Byczki od PowerBI, próbuję robić rank dla opportunities w każdym segmencie, ale czasem wyskakuje mi rank taki sam dla dwóch różnych wartości, co robię nie tak? Próbowałem też odnieść się do całej tabeli (raport), wtedy robi mi ranking poprawnie, ale nie po segmentach.

#powerbi

#powerbi

źródło: 20231122_111842

Pobierz

Treść przeznaczona dla osób powyżej 18 roku życia...

- 2

@DFWAFDS: to takie narzedzie analityczne , ze jak mam dane to bedzie mozna je analizowac, wyciagac wnioski i prezentowac z pomoca tego. Ja tak to rozumiem. Wiec jak podeslesz mi twoje dane z tagu, ja bede mogl je ladnie zaprezentowac :D i moze jakies wnioski wyciagnac z tego. W robocie moze sie przyda, wiec bede mial dane do cwiczen.

konto usunięte via Wykop

- 1

@ChlopoRobotnik2137: sample z roznymi danymi jak cos tutaj

https://learn.microsoft.com/en-us/power-bi/create-reports/sample-datasets

https://learn.microsoft.com/en-us/power-bi/create-reports/sample-datasets

Cześć, chcę trochę podnieść kwalifikację i dostać lepsze stanowisko w korpo. Dlatego zastanawiałem się nad nauką #powerbi Co o tym myślicie? Istnieje jakaś wersja niekomercyjna, którą mogę legalnie wykorzystać w domu do nauki? Jak ktoś miał w tym doświadczenie to mógłby dać znać ile mniej więcej zajęła mu nauka tego narzędzia. #it #praca #pracbaza #samorozwoj #analizadanych

@BrakWolnegoLoginu https://learn.microsoft.com/en-us/credentials/certifications/exams/pl-300/?tab=tab-learning-paths

Na dole masz: items in this collection i kilka modułów ułożonych w kolejności w jakich najlepiej się uczyć.

Polecam to ale pamiętaj, że nie jest to zbyt szczegółowe, bardziej pomaga poznać główne koncepcje i ustrukturyzowac wiedzę

Na dole masz: items in this collection i kilka modułów ułożonych w kolejności w jakich najlepiej się uczyć.

Polecam to ale pamiętaj, że nie jest to zbyt szczegółowe, bardziej pomaga poznać główne koncepcje i ustrukturyzowac wiedzę

@BrakWolnegoLoginu temat power bi jest dużo głębszy i ma większy potencjał niż się może wydawać, specjalizują się w samym power bi, z pomniejszą znajomościa technologii/narzędzi powiązanych, można robić naprawdę sporą kasę. Przejrzyj moje wpisy (nie ma ich wiele), a znajdziesz post z listę tematów w uniwersum power Bi wraz z podziałem na poziomy zaawansowania, które pomogą Ci usestymatyzowac naukę, i nie zgubić żadnego istotnego wątku ze spektrum power Bi.

Cześć, proszę o radę w sprawie kariery Data Analysis - poziom mid.

Obecnie pracuję jako analityk, codziennie piszę zapytania w SQL, zrobiłem też kilka modeli predykcyjnych w Pythonie używanych w firmie. Co jakis czas robię też dashboard w Power BI, ale jest to dość upośledzone, bo nie jest on połączony z bazą danych i bazuję na plikach csv wyplutych z sqlek. Nie używamy chmury. Czuję jednak że mało umiem, zarabiam wręcz za

Obecnie pracuję jako analityk, codziennie piszę zapytania w SQL, zrobiłem też kilka modeli predykcyjnych w Pythonie używanych w firmie. Co jakis czas robię też dashboard w Power BI, ale jest to dość upośledzone, bo nie jest on połączony z bazą danych i bazuję na plikach csv wyplutych z sqlek. Nie używamy chmury. Czuję jednak że mało umiem, zarabiam wręcz za

@rafal9522: z tym schodzeniem to zalezy ile zarabiasz, bo okazac sie moze ze taki koles od ML i junior zarobi porownywalnie/tyle co ty. Kazda z tych sciezek jest ok, poprobuj i zobacz co Cie najbardziej "kreci". Doczytalem o daxie, czyli idziesz w BI. DE i DS nie jest potrzebny dax, lub rzadko

@peoplearestrange dobrze gada - jak robisz DAXa i ci się podoba to idź na PBI Deva. A jeśli chcesz dotknąć chmury nie wkładając w to ani grosza to sięgnij po triala na Azure lub jeszcze wygodniej po triala na Snowflake (w dużym uproszczeniu chmurowa baza danych) - https://signup.snowflake.com/?utm_cta=trial-en-www-homepage-top-right-nav-ss-evg - powinna pojawić się tam baza o nazwie TPCH z randomowymi danymi które będziesz mógł podłączyć do PBI i się pobawić nawet na

- 1

Kto leci do dejta hirołs?

#powerbi

#powerbi

źródło: temp_file1357469265190530211

Pobierz- 0

#powerbi

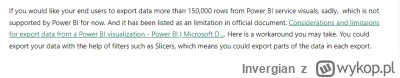

Czy znacie może jakiś sposób aby z tabeli powerbi dało się eksportować więcej niż 150k wierszy? Wersja premium w czymś pomoże?

Czy znacie może jakiś sposób aby z tabeli powerbi dało się eksportować więcej niż 150k wierszy? Wersja premium w czymś pomoże?

@Endrju9: Nie ma takiej opcji niestety :V

źródło: obraz_2023-09-01_215534862

Pobierz@Endrju9: dax studio

Czasami życie jest zabawne. Wpadł w ręce mojej firmy projekt wizualizacji analiz dla rozwiązania nowatorskiego na skalę globalną przy tworzeniu którego bierze udział zespół kilkudziesięciu naukowców. AI, ML, zdjęcia satelitarne i inne tego typu bajery w #powerbi. Szykuje się ciekawa sprawa :)

konto usunięte via Wykop

- 0

@KrzysiekZcleverBI: no bardziej chodzi mi o to, że coś nowatorskiego, AI/ML/ satelitarne? No gdzie tu wykorzystanie biznesowego jednak PBI, gdzie mamy korpo, super integracje z microsoftowymi smieciami itd.

- 0

@cohontes: To jest nieistotne. PBI tutaj służy tylko do zwizualizowania danych.

Ktoś poleci jakieś ciekawe książki w tematyce #businessintelligence #powerbi . Data Warehouse toolkit oraz definitive guude to dax mam już przerobione. Szukam czegoś bardziej zaawansowanego bo w power BI też już trochę pracuje i ostatnie dwie książki jakie sobie gdzieś w necie znalazłem to nic nowego w nich nie było. Coś w tematyce data storytelling polecacie? Warto to przerobić? Czy to bardziej takie pod klikanie wykresów i dobieranie

@peoplearestrange: ale DG nie napisała książki to ciężko coś dobrego polecić

@karmazynowy20: trzeba iść z duchem czasu, myślę że DH >> książka

- 0

Cześć, chciałbym rozpocząć naukę w kierunku analityki. Aktualnie jestem skupiony na nauce Excela, SQL i powerbi. W przyszłości również planuje naukę pythona i środowiska Microsoft azure. Polećcie mi proszę jakieś książki/kursy/filmy, które pozwolą mi na zdobycie gruntownej wiedzy z tego zakresu.

#praca #sql #bi #powerbi #excel #python #azure

#praca #sql #bi #powerbi #excel #python #azure

- 0

@SuperGosc11 z pewnością doradzi, czy dobrze to kwestia podlegającą dyskusji

@malkaj: z czego uczysz się SQLa?

- 0

Mirki, pytanie, czy jest w powerbi mozliwe zliczenie jednej kolumny na podstawie drugiej? Przyklad:

Tabela 1,

Kolumna:

A

B

A

Tabela 1,

Kolumna:

A

B

A

Tak

@brntfgt: a tego to już nie wiem

Jedna z nich, parametr do zmiany wizualizacji na wykresie liniowym z agregacji po miesiącach, do tygodni lub dni - w wizualizacji mam w etykiety danych do bieżącego roku, w przypadku wyboru dni i tygodni etykiet jest za dużo i chciałbym je przy takim wyborze wyłączyć i pokazywać tylko w agregacji do miesięcy, jak to uzyskać?

Drugi problem to parametr do wyboru miar, użytkownik może wybrać

2. zakladka format -> edit interactions, wylacz sobie filtrowanie tym parametrem na wybranych wizualizacjach. W miarach daj sobie default value jakis gdy nic nie jest wybrane w parametrze.