Aktywne Wpisy

soshiu +4

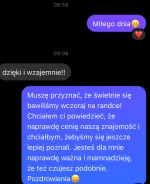

Bylem wczoraj na drugiej randce z dziewczyną poznaną przez #tinder Była bardzo przyjemna. Zalezy mi na niej, co myślicie o tej wiadomości co napisałem? Zbyt nachalnie i za szybko czy okej? #zwiazki #rozowepaski #niebieskiepaski #blackpill

źródło: IMG_5624

Pobierz

WielkiNos +156

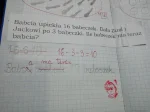

Przecież to jest tragiczne! Zamiast promować, że dziecko fajnie samodzielnie myśli głupia baba pokreśliła wszystko żeby tylko było na jej i żeby dziecko zgnoić. I to już od najmłodszych lat.

Kto tych wariatów zatrudnia? ( ಠ_ಠ)

#szkola #matematyka #bekaznauczycieli

Kto tych wariatów zatrudnia? ( ಠ_ಠ)

#szkola #matematyka #bekaznauczycieli

źródło: temp_file3738988741446937042

Pobierz

mam zagwozdkę. Mam raport w Power Bi, który korzysta z dość dużego dataflow.

Dataflow wchodzi na sharepointa i bierze podzielone pliki excelowe, które są ekstraktem z sapa za każdy dzień i łączy je każdego dnia, później robiąc różne rzeczy. Pojawił się z tym problem. Mianowicie tych plików jest już stanowczo za dużo. Dataflow odświeża się 5-6h, czasem wywalając się.

Rozwiązanie, które chce wdrożyć (wynikające po części z biznesu) jest w teorii proste. 70-80 procent plików historycznych połączyć raz w coś dużego i jedynie je czytać,a resztę, czyli nowe pliki traktować dotychczasową metodą. Nie wiem jednak jak się zabrać za tę pierwszą część. W co spakować te dane? Nie zmieszczą się do excela, a nie chcę bawić się w stawianie bazy. Macie jakieś pomysły?

#businessintelligence #powerbi #analizadanych