https://blog.hackster.io/tensorflow-lite-ported-to-arduino-5e851c094ddc

#elektronika

Wszystko

Najnowsze

Archiwum

źródło: comment_BfN63KXq3lnIWSzqsbTfGK3uTq9Rc2sq.jpg

Pobierzopenclnvidiageforcegt540m.0 : NVIDIA Corporation GeForce GT 540M

źródło: comment_kFThL0Rw0LrXzbYcMyWt2OQ8i4CWQOi9.jpg

Pobierz

źródło: comment_mYMyvgliFqVbeNRNCOE3GrfhPwSgrVeD.jpg

Pobierz

źródło: comment_hE4wOL0TD1gTMUwQjZahzXydgKaiGVm5.jpg

Pobierz

źródło: comment_GqE1Bvh8fZubykztQUNaJV26LHAi3Pxi.jpg

Pobierz

źródło: comment_LeJ30CBJqh5xgYJOmnmAaxks7ekA7HeJ.jpg

Pobierz9

Prosty tutorial jak samodzielnie w 20 minut przygotować środowisku do samodzielnej zabawy z DeepDream (obrazy i filmy) i się o tym przekonać.

z34

Procesory z architekturą RISC-V stają się coraz popularniejsze i coraz tańsze. Otwarta licencja sprzyja eksperymentom i umożliwia stosunkowo łatwą integrację z najnowszymi rozwiązaniami. Firma Sipeed wypuszcza na rynek kolejny moduł z rozwiązaniem konkurencyjnym dla popularnych rdzeni...

zRegulamin

Reklama

Kontakt

O nas

FAQ

Osiągnięcia

Ranking

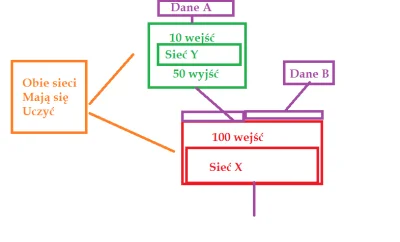

1) keras.layers.Embedding layer

2) modelami vec2vec, glove

Próbuję to zrozumieć w kontekście NLP, ale szersze naprowadzenie bardzo mile widziane :)

#python #machinelearning #keras #tensorflow #nlp