http://www.learndatasci.com/free-data-science-books/

http://www.kdnuggets.com/2015/09/free-data-science-books.html

#whatadata – analiza i wizualizacja danych, statystyka, ciekawostki z półświatka Data Science ( ͡° ͜ʖ ͡°)

- Nevadaaa

- sokytsinolop

- Rajca

- Kid_A

- Ostrzewtlumie

- +18 innych

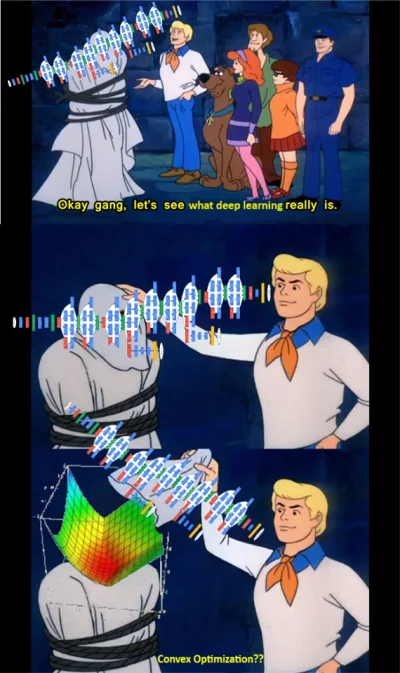

Mam do przetworzenia bardzo dużo dokumentów tekstowych i będę chciał z nich wyciągnąć pewne zależności i porobić kilka innych rzeczy związanych uczeniem sieci.

Co polecacie do tego? Równocześnie, żeby było to jakieś nowe rozwiązanie, którego warto się uczyć.

TensorFlow+Java/Python?

Deeplearning4j+Java?

Theano+Python? Keras+Python?

Apache Spark? Apache Hadoop?

A może jest coś jeszcze fajniejszego? Może coś z nowymi językami programowania? Scala? Cloujure? Groovy? Kotlin?

Gdzie szukać takich nowinek?