✨️ Obserwuj #mirkoanonim

Dlaczego niektóre #rozowepaski (w wieku +35) na #tinder nie mają swoich zdjęć, albo na wszystkich zdjęciach są w okularach przeciwsłonecznych na pół twarzy? Niska samoocena, czy o co chodzi? Zagadujecie do takich dziewczyn, czy szkoda czasu? Jak sprytnie poprosić o więcej zdjęć, ale tak, żeby nie pomyślała, że zależy mi tylko na jej wyglądzie?

────────

Dlaczego niektóre #rozowepaski (w wieku +35) na #tinder nie mają swoich zdjęć, albo na wszystkich zdjęciach są w okularach przeciwsłonecznych na pół twarzy? Niska samoocena, czy o co chodzi? Zagadujecie do takich dziewczyn, czy szkoda czasu? Jak sprytnie poprosić o więcej zdjęć, ale tak, żeby nie pomyślała, że zależy mi tylko na jej wyglądzie?

────────

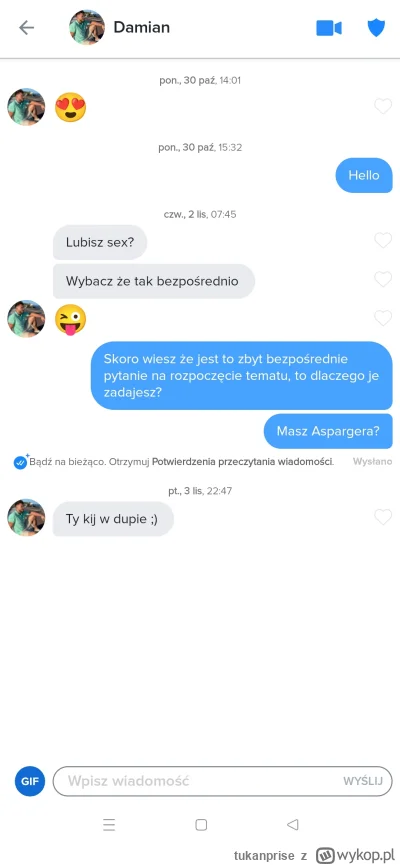

@mrsopelek: czyli robiła to do czego 90% facetów na tagu aspiruje patrząc po wpisach xD