Aktywne Wpisy

Damianooo_421 +295

Mirki pijcie ze mną kompot, po latach jeżdżenia gównami co mają 100 km w końcu kupiłem normalne, komfortowe auto i ma ponad 200 kucy.

Volvo s80 2.5t 2010r

#motoryzacja #samochody #chwalesie

Volvo s80 2.5t 2010r

#motoryzacja #samochody #chwalesie

źródło: temp_file6183910751691884725

Pobierz

ApropoDefakto +176

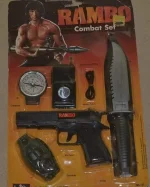

#gimbynieznajo Był w każdym sklepie z zabawkami, chyba w większości kiosków ruchu na wystawie. Kosztował kilka złotych, nie umiem sobie przypomnieć czy tak kiedyś posiadałem, ale ta krótkofalówka to na pewno była w zestawie policjanta który miałem XD

źródło: temp_file8807065248210837119

Pobierz

![[AMA] Tomasz Czukiewski - autor kanału CiekaweHistorie](https://wykop.pl/cdn/c3397993/64d0df2e4b21c538cb4a0d442c55d8a5d24c49137a4f5979580a3f4517fbf1f0,q80.jpg)

źródło: agi

PobierzPodobno jak takie AI osiągnie 160-240 miliardów neuronów (ifów hehe) to dopiero przewyższy człowieka. Ciekawy jestem jak szybko dobiją do takiej liczby

Ale poza pracą, po części też uczelnianie,

@JamesJoyce: super że to poruszyłeś, ponieważ uważam że AGI także powinno działać stabilnie, a z modeli typu LLM korzystać jedynie do komunikacji ze światem zewnętrznym, ale sam proces decyzyjny powinien być w 100% przejrzysty.

Uważam też że kluczową umiejętnością AGI jest umiejętność rozwoju własnego kodu i kodu swoich pluginów. Jeżeli AI będzie w stanie

@JamesJoyce: skalujemy modele ponieważ chcemy wiedzieć jakie to przyniesie efekty i zdobyć doświadczenie które pomoże nam podejmować decyzje przy dalszym rozwoju AI. Jednak co do ducha to trzeba by bylo najpierw udowodnić że ludzie

źródło: karpathy

Pobierz