Aktywne Wpisy

Nobody32 +662

Co do tej afery z #giftpol, to pokazuje ona świetnie podejście do pracy ludzi 20-35 lat a 40+. Nasi rodzice/dziadkowie byli nauczeni, że szef to pan i koniec. Dzisiaj starsze pokolenie mówi, że młodym się w dupach poprzewracało, bo mają czelność czegoś żądać. A chodzi dokładniej o traktowanie pracownika jak człowieka i przestrzegania prawa pracy. I wiecie co? I bardzo dobrze. Młode pokolenie idealne nie jest, ale przynajmniej nie daje się

mourise +960

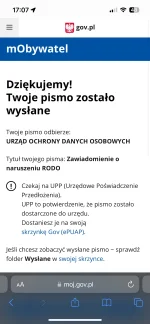

Mireczki. Jest mi bardzo wstyd ( ͡° ʖ̯ ͡°) Całkowitym przypadkiem stworzyłem zgłoszenie naruszenia rodo przez #giftpol w oświadczeniu ich mecenasa „dziura w dupie” i przesłałem do Prezesa UODO. Jest mi wstyd, że przyczyniam się do szargania reputacji tej znakomitej firmy ( ͡° ʖ̯ ͡°) #januszebiznesu

źródło: Zdjęcie z biblioteki

Pobierz

Szanujmy swój czas.

źródło: comment_16439867533Pd8rzEC1vdj3HD45MBDhy.jpg

Pobierz@dendrofag: ale tu chodzi o szanowanie czasu procesora xD

ps. w zasadzie można to pokryć to testami udowadniającymi jak pomijalnie mały jest błąd i nawet OP zrozumiałby że to ma sens (ʘ‿ʘ)

pps. ciekawe czy współcześnie jakimiś heurystycznymi algorytmami albo ML wynajduje się dużo podobnych optymalizacji

https://www.youtube.com/watch?v=p8u_k2LIZyo

20min, ale błyskawicznie zlatuje.

Teraz po prostu dokupujesz kolejną kość pamięci, albo wymieniasz procesor na nowszy model i problem załatwiony.