(SwissDevJobs.ch | LinkedIn | Twitter | Facebook)

(GermanTechJobs.de | LinkedIn | Twitter |

Wszystko

Najnowsze

Archiwum

źródło: comment_1637146504dGplFndNOzAAF6ppVM6cKI.jpg

Pobierza cos z sysadm będzie?

Apache Ambari

8

Get free access to any standalone course, Specialization, or Professional Certificate from Google Cloud. Offer valid through November 6, 2021. No limit per learner.

z

źródło: comment_16341147511WPJQ7C9Gg4i1ma8sTnz3s.jpg

Pobierz

źródło: comment_16310912850TL7B9mUo3xnGqcTSWQtzN.jpg

Pobierz3

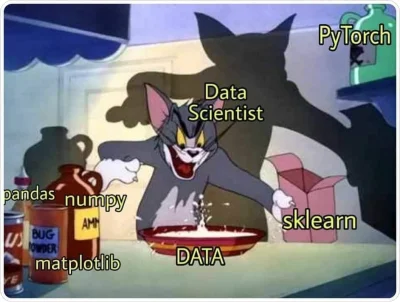

Apache Spark jest to platforma umożliwiająca przetwarzanie ogromnych zbiorów danych w środowisku rozproszonym. Okazuje się jednak, że równie łatwo możemy korzystać ze Sparka na lokalnym komputerze. Oprócz trybu lokalnego możemy również zbudować własny klaster przy pomocy kontenerów Docker'a.

z

źródło: comment_1628068794G7oBy6uQ8pSzrrWZuC4oE2.jpg

PobierzKomentarz usunięty przez moderatora

źródło: comment_16244405399L5asBuGwKy6s0wZGHdD5i.jpg

Pobierz

źródło: comment_1621415156ny3GsZFMMkHGsErsPZ0MTy.jpg

Pobierz

źródło: comment_1618394521GDmLmIaW6WCCsYediVXJcU.jpg

Pobierz

źródło: comment_1595715799r0qzy4X8hJ1zOMabEOs6K9.jpg

PobierzRegulamin

Reklama

Kontakt

O nas

FAQ

Osiągnięcia

Ranking

#programowanie #bigdata