Może głupie pytanie ale jestem ciekaw odpowiedzi. Z wykorzystaniem której implementacji RDBMS uczyliście się baz, sql itd. - Oracle, Microsoft'u, MySQL, PostgreSQL (czy jeszcze czegoś innego) ? I którą polecilibyście osobie wchodzącej dopiero w ten segment IT np. pod kątem pracy (ofert) czyli mówimy tu o pracy właśnie z bazami (jako główny obszar)

#bazydanych #informatyka #programowanie #sql

#bazydanych #informatyka #programowanie #sql

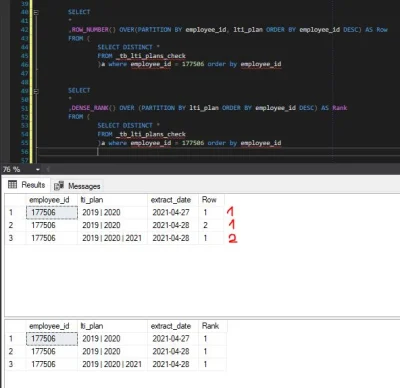

A jak chcesz się za to zabrać to zrób to dobrze, tak aby niczego nie zablokować

¯\_(ツ)_/¯

A najlepiej najpierw przetestuj na środowisku zapsowym. Skoro to istotny system to na pewno takie środowisko gdzieś obok stoi