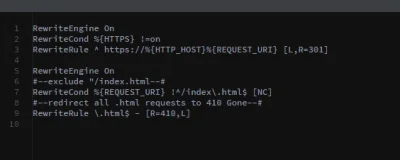

Mirasy, chciałbym aby KAŻDA dotychczasowa podstrona i adres uzyskała status 410 gone, ewentualnie z wyjątkiem index.html który został jako lekki statyczny landing. Czy robię to dobrze w .htaccess?

Przy okazji pytanie czy powielać "RewriteEngine On"? Pierwszy 'akapit' dotyczy https, chodzi o drugi rzecz jasna :)

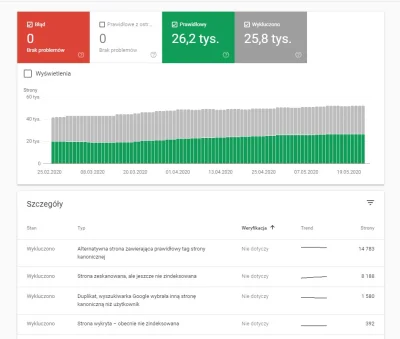

Jak @OnRise zasugerował 410 jest lepszym rozwiązaniem dla indeksowania i Google Search Console niż sypanie 404 które już widzę Google wykazuje jako błędy. Cel to usunięcie 26,2

Przy okazji pytanie czy powielać "RewriteEngine On"? Pierwszy 'akapit' dotyczy https, chodzi o drugi rzecz jasna :)

Jak @OnRise zasugerował 410 jest lepszym rozwiązaniem dla indeksowania i Google Search Console niż sypanie 404 które już widzę Google wykazuje jako błędy. Cel to usunięcie 26,2

Nie dostaję żadnego błędu, żadnej cofki. Mam włączoną indeksację, wszystkie inne podstrony księguje poza zbiorem aktualności i

źródło: comment_1637071529a8U6yCUiXzAM9gAsHJVCgU.jpg

Pobierz@Floydian: W niektórych przypadkach niektórzy po 2 miesiące nie mogą się doprosić, czasami działa szybko, czasami nie.