Wszystko

Wszystkie

Archiwum

- 0

@Tomborus przewoziłem taki materac Reno kango z traficara i musiałem drzwi sznurkiem wiązać bo się nie zamknęły, dacia jest chyba mniejsza, więc pewnie też Będziesz musiał sznurować drzwi.

@Tomborus ryzyk fizyk albo wybierasz dużego i masz pewność albo średniego z ryzykiem że nie wciśniesz

- 5

Uwaga, bezcelowe pi...nie :P

Eh niby ten #truenas działa ale jakoś tak nie wiem. Nie jestem fanem. Znowu pewnie się skończy na czystym alpine albo debianie i odpaleniu dockera i pisaniu confa samby z palca. Nie to że generowany przez truenas jakoś super działa, np.

Scale używa te (niepopularna opinia) gówniane kubernetes które gdy nie masz 50 serwerów do skalowania i storage w ceph jest po prostu wolny i upierdliwy, ale za to wywala serwisy gdy uruchomimy na słabym sprzęcie w jednej kopii, czyli np. domowy NAS

Można mocno dłutem i młotem przerobić by był czysty docker ale to wiadomo, niewspierane

Eh niby ten #truenas działa ale jakoś tak nie wiem. Nie jestem fanem. Znowu pewnie się skończy na czystym alpine albo debianie i odpaleniu dockera i pisaniu confa samby z palca. Nie to że generowany przez truenas jakoś super działa, np.

multi home time machine nie działa, trzeba zrobić private homes czy jakoś tak i tam włączyć time machine, bo ponieważ takScale używa te (niepopularna opinia) gówniane kubernetes które gdy nie masz 50 serwerów do skalowania i storage w ceph jest po prostu wolny i upierdliwy, ale za to wywala serwisy gdy uruchomimy na słabym sprzęcie w jednej kopii, czyli np. domowy NAS

Można mocno dłutem i młotem przerobić by był czysty docker ale to wiadomo, niewspierane

źródło: maxresdefault

Pobierz@assninja: dlatego sam rozpatruję ostatnio posadzenie proxmoxa i wtedy można korzystać z zalet więcej niż jednego systemu. Instalujesz truenas core/omv (tak core) jako jedna vmka, oddajesz mu cały kontroler sata wraz z dyskami i na nich sadzisz zfs. W pozostałych vm (albo w poprzednim) metodą byle prościej konfigurujesz apikacje, a jak potrzebują dobrać się do danych, to po nfs udostępnionym z truenas/omv. Można też posadzić coś prostszego np. openmediavault plus

- 0

@mesje_labul: kiedyś miałem dokładnie ten setup tylko chyba miałem passthrough dysków a nie całego kontrolera bo się nie dało :)

tylko w pewnym sensie truenas ma racje - by nie komplikowac. To ma bezpiecznie trzymac pliki

dlatego ostatecznie zawsze koncze z debianem / proxmoxem / alpine i tam z palca napisany config samby, zfs i /data/foo :)

tylko w pewnym sensie truenas ma racje - by nie komplikowac. To ma bezpiecznie trzymac pliki

dlatego ostatecznie zawsze koncze z debianem / proxmoxem / alpine i tam z palca napisany config samby, zfs i /data/foo :)

- 1

- 0

Mireczki, bo się zajebe, a chat gpt cos mi ciągle miesza.

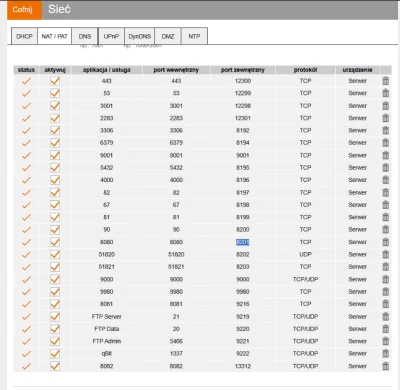

Mam w kontenerach #docker apki które działaja na porcie UDP 51820. Chcę dla każdego kontenera uzyskać inny publiczny adres IP. Na pewno udałoby się to z openvpn, ale nijak spina się to finansowo. Chat powiedział, że jak znajdę proxy, które obsługuje UDP to uda się to zrobić. Prawda? Ogarnałem takie proxy, próbuję to rozgryźć, pcha mnie ciągle w redsocks2, ale mam problem z instalacją tego.

Dajcie proszę znać czy jest to do osiągnięcia przez proxy UDP, jeśli tak to jakim rozwiązaniem najlepiej to ugryźć?

Dzięki!

Mam w kontenerach #docker apki które działaja na porcie UDP 51820. Chcę dla każdego kontenera uzyskać inny publiczny adres IP. Na pewno udałoby się to z openvpn, ale nijak spina się to finansowo. Chat powiedział, że jak znajdę proxy, które obsługuje UDP to uda się to zrobić. Prawda? Ogarnałem takie proxy, próbuję to rozgryźć, pcha mnie ciągle w redsocks2, ale mam problem z instalacją tego.

Dajcie proszę znać czy jest to do osiągnięcia przez proxy UDP, jeśli tak to jakim rozwiązaniem najlepiej to ugryźć?

Dzięki!

@jannekk: przede wszystkim VPS musi mieć więcej niż 1 IP

Koleje e IP sa platne

majac IP na linuxie, bindujesz pewnie dockera przy odpalaniu do odpowiedniego IP

Koleje e IP sa platne

majac IP na linuxie, bindujesz pewnie dockera przy odpalaniu do odpowiedniego IP

Załóż free tier na azure, napiszta kod w terraform który będzie zakładał nową vmke z tym twoim dockerem, kasuj i zakładaj od nowa.

- 0

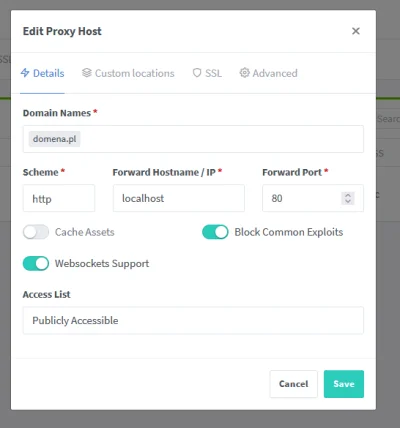

Mirki, jakieś pomysł jak w nginx proxy manager albo traefik ustawic zeby ruch szedl do kontenerow nie przez subdomene tylko przez konktetny url? Dla domena.pl chce ustawic aby ruch szedl to kontenera z httpd, dla domena.pl/nextcloud chce zeby ruch szedl do kontenera z nextcloud. Probowalem juz chyba wszystkiego, albo nic nie dziala, albo /nextcloud wywoluje sie w kontenerze z httpd.

#linux #komputery #informatyka #selfhosted

#linux #komputery #informatyka #selfhosted

- 0

@Czlowiek_Ludzki: aktualnie przy takim configu udalo mi sie osiagnac 500 internal server error, a powinno pokazas cie defaultowe greetings od npm

źródło: Bez tytułu

Pobierz- 0

dobra k---a caly czas cos k---a musi dzialac na odwrot, j----y cloudflare i docker nie mam juz sil do tej k---y

Mam w planach zrobić format domowego serwera bo wszystko działa doskonale, ale trzyma się to na słowo honoru ( ͡° ͜ʖ ͡°) a chciałbym teraz zrobić wszystko jeszcze raz i po bożemu. Tu kilka pytań:

1. ext4, Btrfs czy ZFS? Dwa ostatnie ze względu na deduplikację (może się przyda przy kontenerach?)

2. Używać konteneryzacji kiedy tylko się da, nie używać wcale czy to w zasadzie bez większej rożnicy?

1. ext4, Btrfs czy ZFS? Dwa ostatnie ze względu na deduplikację (może się przyda przy kontenerach?)

2. Używać konteneryzacji kiedy tylko się da, nie używać wcale czy to w zasadzie bez większej rożnicy?

@Czlowiek_Ludzki:

1. ext4 - po prostu działa ¯\(ツ)/¯

2. używać kiedy tylko się da - łatwiej jest utrzymać porządek i jak masz popisane ładnie docker-compose, to bardzo łatwo potem odtworzyć konfigurację po formacie lub na innym sprzęcie.

1. ext4 - po prostu działa ¯\(ツ)/¯

2. używać kiedy tylko się da - łatwiej jest utrzymać porządek i jak masz popisane ładnie docker-compose, to bardzo łatwo potem odtworzyć konfigurację po formacie lub na innym sprzęcie.

ja też mam malutki serwerek, mam 512gb nvme i 16gb ramu, po prostu myślałem że bawiąc się btrfs i zfs uda mi się zaoszczędzić więcej fizycznej przestrzeni dyskowej ( ͡° ͜ʖ ͡°)

@Czlowiek_Ludzki: no to już bym optował w kierunku btrfs/zfs. Kompresja to darmowa przestrzeń, lepsze i/o, za cenę minimalnie większego użycia cpu (kompresja zstd=3) i może nieco większych opóźnień (?).

- 3

Ostatnio odkryłem że aplikację rust można skompilować z musl i apki można odpalać w docker scratch (。◕‿‿◕。) to jest takie wspaniałe. Teraz pody wstają w 3 sekundy i mają coś koło 10mb (づ•﹏•)づ #rustlang #docker #kubernetes

- 0

Jak ustawić, że w #proxmox po zaniku prądu uruchamiały się tylko ostatnio załączone usługi a nie wszystkie dostępne? #wirtualizacja #docker #kontenery

@art212 rozumiem, jednak normalnie gdy pytam publiczną waść o rozwiazanie problemu to najpierw notuje to juz ustaliłem, co sprawdziłem, co weryfikowalem. Tutaj op nie sprawdził nawet najprostszych rzeczy, a przynajmniej o nich nie napisał

Czemu sam op'owi nie odpiszesz co ma robić skoro wiesz że czat gpt "nie jest dobry" w takie klocki?

Czemu sam op'owi nie odpiszesz co ma robić skoro wiesz że czat gpt "nie jest dobry" w takie klocki?

✨️ Obserwuj #mirkoanonim

Hej.

Potrzebuję dla mniejszej społeczności stworzyć portal. Chcemy zebrać i podzielić się zdjęciami i plikami z naszych eventów. Chciałbym oprzeć się o rozwiązania #opensource #linux ewentualnie #docker.

Funkcjonalności podstawowe, jakie miałby spełniać portal:

- portal serwuje katalogi z plikami (fajnie by było gdyby były miniaturki do zdjęć) dostępne publicznie - bez potrzeby logowania

Hej.

Potrzebuję dla mniejszej społeczności stworzyć portal. Chcemy zebrać i podzielić się zdjęciami i plikami z naszych eventów. Chciałbym oprzeć się o rozwiązania #opensource #linux ewentualnie #docker.

Funkcjonalności podstawowe, jakie miałby spełniać portal:

- portal serwuje katalogi z plikami (fajnie by było gdyby były miniaturki do zdjęć) dostępne publicznie - bez potrzeby logowania

@mirko_anonim: PHP by Przemo

@mirko_anonim: Może zwykły serwer FTP cię zadowoli?

- 1

Mam debiana w dockerze, jest on komponentem wykonującym jakąś pracę w przetwarzaniu danych, muszę napisać żeby podczas uruchomienia sprawdził czy jest połączenie z bazą danych, oraz czy "następnik" do którego będę strumieniował dane jest gotowy do nasłuchu, dochodzi też bycie konsumentem kafka, a to wszystko w jednym kontenerze, kilka programów które muszą się dogadać.

Jak to elegancko zrobić?

W skrócie: Debian; jeden kontener; 3 programy; każdy w innej technologii, robi coś innego, 2 z nich muszą działać jednocześnie, komunikują się HTTP

No chyba że wywalić wszyskto co osobnych service i docker compose.

Jak to elegancko zrobić?

W skrócie: Debian; jeden kontener; 3 programy; każdy w innej technologii, robi coś innego, 2 z nich muszą działać jednocześnie, komunikują się HTTP

No chyba że wywalić wszyskto co osobnych service i docker compose.

Jak to nie musi być w dockerze (bo nie potrzebujesz docker buildów i wersjonowania obrazów) tylko po prostu ma być skonteryzowane to w ogóle bym zszedł z dockera i postawił do na nspawn albo lxc.

@Kryspin013: użycie technologii których nikt nie zna zamiast najbardziej powszechnych na świecie to zawsze plus

@Kryspin013: użycie technologii których nikt nie zna zamiast najbardziej powszechnych na świecie to zawsze plus

@Boska_Klaudia: Używanie technologii na siłę przeznaczonych kompletnie do czego innego, niezgodnie z ich paradygmatami i tylko dlatego, ze są popularne też.

Uszanowanko. Od jakiegoś czasu dłubię sobie na swoim domowym #nas opartym o #omv . Postawiłem sobie #geoserver w kontenerze #docker Następnie utworzyłem katalog SMB, gdzie chcę wrzucać dane do opublikowania. Mam jednak problem, że przy opcji dodawania rastra Geoserver nie widzi mojego katalogu z danymi. Jak go dodać do tego okienka(pic rel)? W dokumentacji nie znalazłem nic takiego, a tutoriale z yt bazują głównie

źródło: image

Pobierz- 0

Szukam jakiegoś hostingu do dockera, który posiada serwery w PL. Sytuacja jest taka, że chciałbym aby aplikacje były odpalone non stop, każdy na innym adresie ip. Łącznie około 5 aplikacji (małowymagających). Mogą być to serwery rozliczeniowe per minuta lub stała opłata miesięczna. W grę wchodzą propozycje, jeden konterner jedna opłata, jak i rozwiązania, jeden większy hosting na którym jest docker compose. Ktoś coś poleci? :D Korzystałem z opcji Google Cloud, Jak i

@TheXiben: jak na minuty to polecam tiktalik. Jest polska lokalizacja. Jest też nawet api, które pozwoli ci zarządzać serwerami, żeby nie żarły jak są niepotrzebne.

@TheXiben: nie trzymam tam niewiadomo czego, wiec nie wiem jak ze stabilnością. Jak jadę za granicę to sobie tam stawiam wireguarda, żeby się z polskiej lokalizacji logować w różne miejsca i do tego od paru lat się sprawdza znakomicie.

- 0

Komentarz usunięty przez autora Wpisu

@lukgol trochę dziwny wpis. Prawie każdy tag z innej parafii. Co chciałbyś zrobić? Dokumentacja, YT, udemy itp nie odpowiadają?

- 0

@lukgol: dokumentacji php.net, phptherightway.com

@lukgol: AI nie jest dobrym narzędziem do nauki programowania. On jest do tego, aby "pomóc" rozwiązywać problem, a nie żeby się od niego uczyć pisania kodu. Szczególnie, jak uczy się on na naszym kodzie, to zaczyna odpowiadać tylko na tyle, aby rozwiązać problem, a nie do końca będzie "uczył" użytkownika. Widziałem takie przepiękne kwiatki jak podpowiadanie przez AI używania

global.- 0

W ramach treningu react native, zrobiłem swoją pierwszą apkę z fiszkami dla programistów, dostępną w sklepach app store i google play.

App Store: https://apps.apple.com/us/app/it-flashcards/id6496431819

Google Play: https://play.google.com/store/apps/details?id=com.omernet.flashcards

Gdyby ktoś chciał potestować, przygotowałem dostęp do wszystkich fiszek z subskrypcją Premium.

App Store: https://apps.apple.com/us/app/it-flashcards/id6496431819

Google Play: https://play.google.com/store/apps/details?id=com.omernet.flashcards

Gdyby ktoś chciał potestować, przygotowałem dostęp do wszystkich fiszek z subskrypcją Premium.

@Omer86: Co mi daje premium w takiej aplikacji?

6JPYJ46EYFXL

Wykorzystany, dzięki.

- 0

Pytanie do bardziej doświadczonych w #testowanieoprogramowania:

Poradziłem sobie już z testami #cypress w #docker osobno dla API i osobno dla komponentów (aplikacja na dwóch repozytoriach: frontend i API). Podejrzewam, że wrzucenie tego w pipeline to formalność (mam doświadczenie z bitbucketa, teraz pracuję na azure).

Sen z powiek spędzają mi testy e2e i chyba jedyne co do głowy mi przychodzi to nightly buildy na testowy serwer

Poradziłem sobie już z testami #cypress w #docker osobno dla API i osobno dla komponentów (aplikacja na dwóch repozytoriach: frontend i API). Podejrzewam, że wrzucenie tego w pipeline to formalność (mam doświadczenie z bitbucketa, teraz pracuję na azure).

Sen z powiek spędzają mi testy e2e i chyba jedyne co do głowy mi przychodzi to nightly buildy na testowy serwer

@imo0mfg:

pierwsza opcja: mockujesz api uzywajac msw https://mswjs.io/ czy pod playwrighta https://www.npmjs.com/package/playwright-msw po cypresa tez pewnie cos jest, najprostsza, najszybsza

opcja druga: no pewnie masz te rzeczy budowane do obrazow dockera, nie wiem jak to teraz wyglada w azure, wiec powiem na podstawie gitlaba czy tam bitbucketa bo dziala

pierwsza opcja: mockujesz api uzywajac msw https://mswjs.io/ czy pod playwrighta https://www.npmjs.com/package/playwright-msw po cypresa tez pewnie cos jest, najprostsza, najszybsza

opcja druga: no pewnie masz te rzeczy budowane do obrazow dockera, nie wiem jak to teraz wyglada w azure, wiec powiem na podstawie gitlaba czy tam bitbucketa bo dziala

@imo0mfg: docker compose up backend docker compose up frontend, aktualizujesz repo z testami, docker compose run tests --env=local. Gdzie do locala masz przypisany localhost. Jak odpalasz na srodowisku testowym to --env=dev test staging czy jak tam macie??

Druga opcja to monorepo

Druga opcja to monorepo

- 0

Czy jakiś miły wykopek który zna się na wymienionych wyżej tagach pomógłby w instalacji forum na VPS na kanale głosowym? max godzinkę w dowolym terminie, oczywiście nie za darmo bo się z tym bawię trzeci dzień ( ͡° ʖ̯ ͡°)

A tak próbowałeś?