Zrobiłem listę 64 różnych języków programowania i w tagu:

#bitwyjezykowe

będziemy sobie je porównywać który lepszy

W lewym narożniku #awk potężny język przetwarzania tekstu

W prawym narożniku #bash król powłok systemowych jak król jest lwem dżungli

głosowanie plusami w kometarzach

#bitwyjezykowe

będziemy sobie je porównywać który lepszy

W lewym narożniku #awk potężny język przetwarzania tekstu

W prawym narożniku #bash król powłok systemowych jak król jest lwem dżungli

głosowanie plusami w kometarzach

źródło: comment_1649405187MeBVtTp0IiCt6iLM26okHQ.jpg

Pobierz

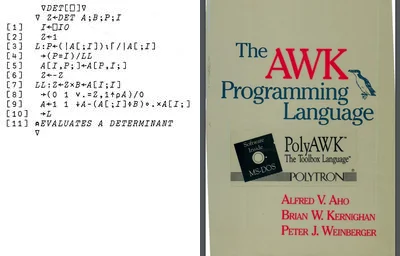

A czy wiesz jak powstał? Jeśli nie, to koniecznie wpadnij na naszego bloga, gdzie znajdziesz artykuł z krótką historią i genezą AWK.

Link do wpisu znajdziesz tutaj: https://blog.askomputer.pl/krotka-historia-i-geneza-awk/

#informatyk #informatyka #awk #it

źródło: 393510528_122103703154075368_3603921288341788957_n

Pobierz